Тесты видеокарт

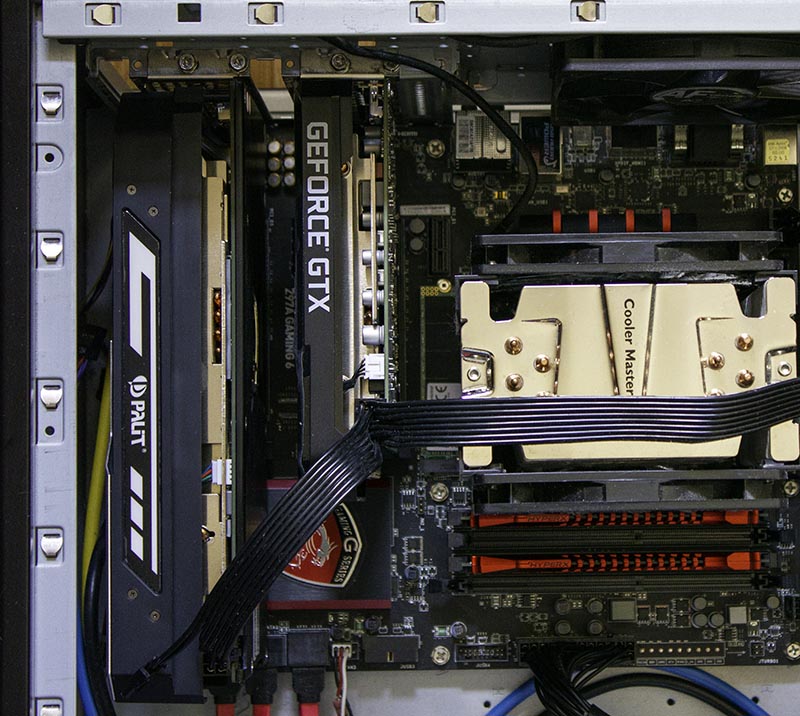

Данный тест не планировался, но по стечению обстоятельств, был добавлен как одна из частей тестирования видеокарты Palit GeForce GTX 1660 Ti StormX OC (NE6166TS18J9-161F), при сравнении её с одноклассником предыдущего поколения Palit GeForce GTX 1060 Super JetStream (NE51060S15J9-1060J).

А также ниже будет ответ на некоторые вопросы, в том числе и о том как наполняется сайт "контентом".

Очень большое количество материала на сайте, это ответы на часто задаваемые вопросы (FAQ). Также при анонсе тестирования данных видеокарт в группе ВК по Adobe Premiere Pro спрашивалось в каких задачах протестировать эти чипсеты.

Учитываются пожелания и критика, например чтобы не разводить холиваров, просто тестировались видеокарты обоих производителей чипсетов AMD и nVidia. Есть скрины загрузок, описана методика, есть результаты. Но тут всплывают два момента: почему нет выводов (или он короткий) и почему нет топовых видеокарт, кому нужны эти тесты бюджетных видеокарт?

Также популярен вопрос, вот у вас тесты в Adobe Premiere Pro CC 2017, а у меня версия Adobe Premiere Pro CC 2018...

На практике ответим на два вопроса, и заодно "протестируем" движок Lumetri Deep Color Engine.

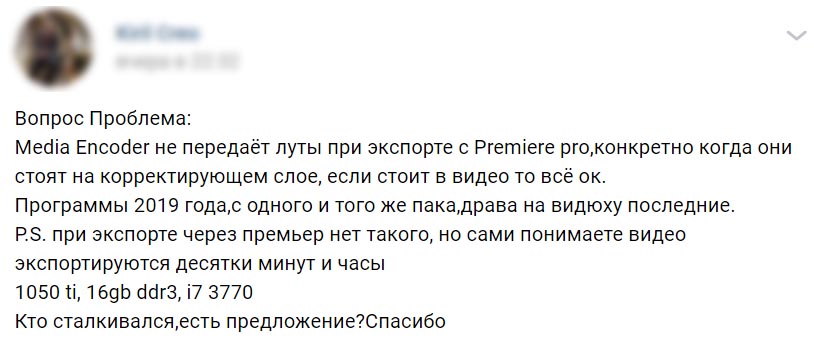

Один из вопросов: потеря применённого LUT-а к регулирующему слою, при рендеринге средствами программы Adobe Media Encoder CC 2019.

Как правило приходится проверять очень много похожих случаев, но малая часть их попадает в "базу" сайта, потому что это как правило локальная ошибка конкретной рабочей станции.

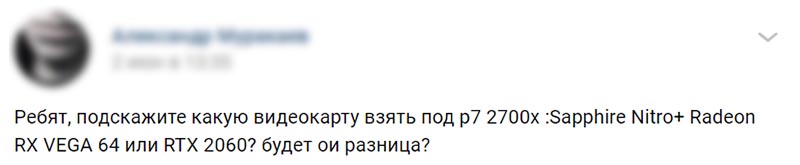

Второй момент вырос из этого вопроса:

И получен был следующий ответ:

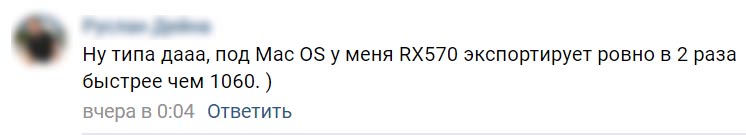

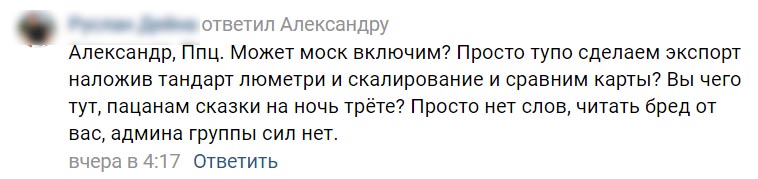

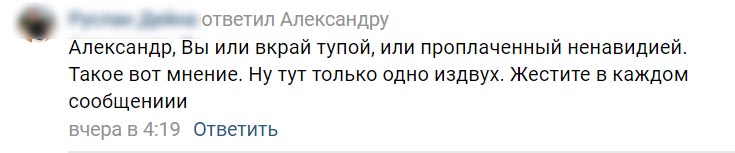

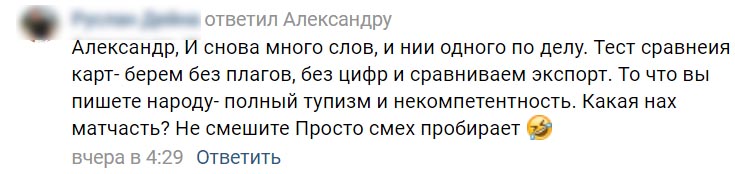

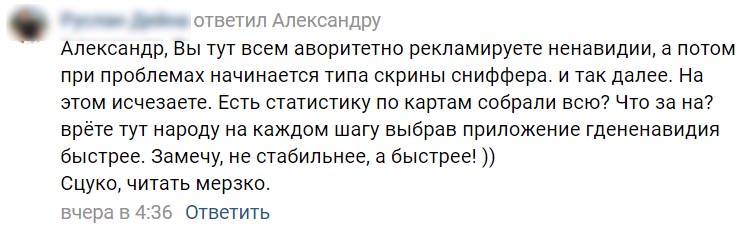

На что один из пользователей оставил следующий комментарий:

На данное утверждение были даны два скрина: AMD Radeon RX 570 (mac OS) и NVIDIA GeForce GTX 1060 (Windows 7), сделанные в одном бенчмарке NeatBench5. Чем больше frames/sec, тем лучше (быстрее видеокарта).

Подобная методика была отвергнута (кому нужны эти шумодавы, я ими не пользуюсь и т.д.). И была предложена своя: люметри + скалинг.

Давайте разбираться, зачем берутся тяжёлые сторонние плагины для тестирования видеокарт, и почему движком Lumetri Deep Color Engine трудно что-то протестировать.

Основная ошибка тех кто так рассуждает или пробует тестировать видеокарты (люметри + скалинг) в следующем: на YouTube полно роликов, где люди берут условно видеокарты GeForce GTX 1650 и GeForce RTX 2080 Ti, выводят простой проект (как предложено ниже), и получают одинаковое время. Раз нет разницы, зачем покупать дороже? Это логично, для подбора оптимальной видеокарты для конкретных задач. Но, это не тестирование видеокарт, кому нужны тесты видеокарт, где участвуют 20 видеокарт на разных чипсетах и у всех одно и тоже время рендеринга?

Поэтому на простых проектах со штатными эффектами, чтобы увидеть разницу даже у бюджетных видеокарт, надо применять кучу штатных эффектов к клипам, использовать несколько слоёв, делать "картинку в картинке" (читаем даунскалинг), и в принципе можно в итоге всё равно получить очень близкое время у всех испытуемых. Такое характерно и для других программ, например при использовании фирменного проекта бенчмарка PressReleaseProject.veg (VP11 Benchmark), бюджетные и видеокарты среднего ценового диапазона, имеют очень близкие результаты.

Как итог может сложиться ошибочное мнение, что видеокарта не играет никакой роли, и потом применить какой-то плагин и получить увеличение времени рендеринга в 20 раз.

Задача подобных тестирований, именно создать ситуацию когда будет видна разница между любыми видеокартами, а не тестить GeForce RTX 2080/Vega 64 на проекте, где на стыках установлены только кроссдиссолвы.

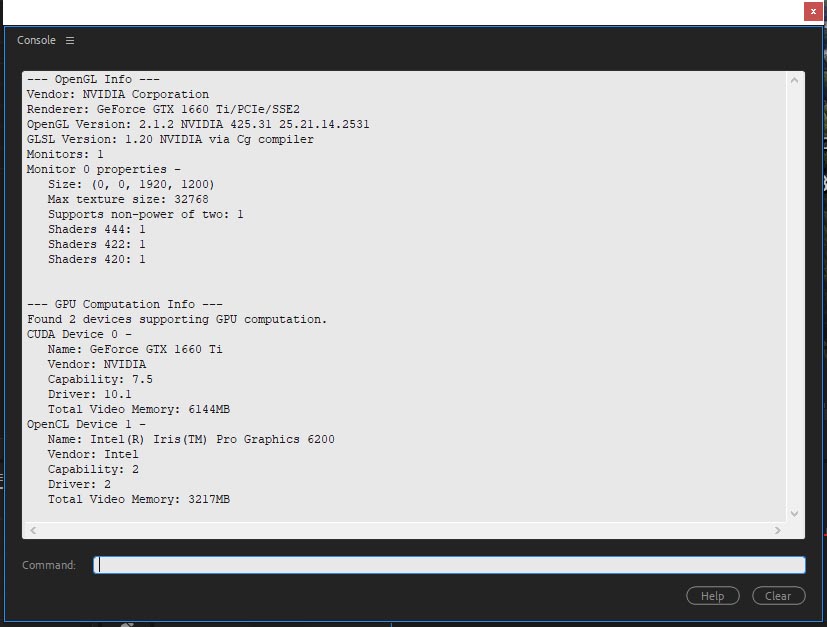

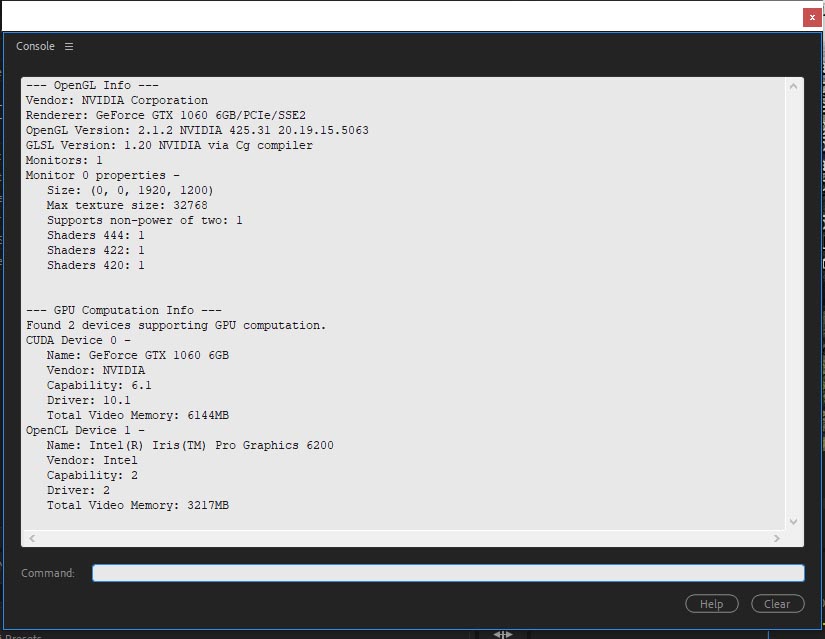

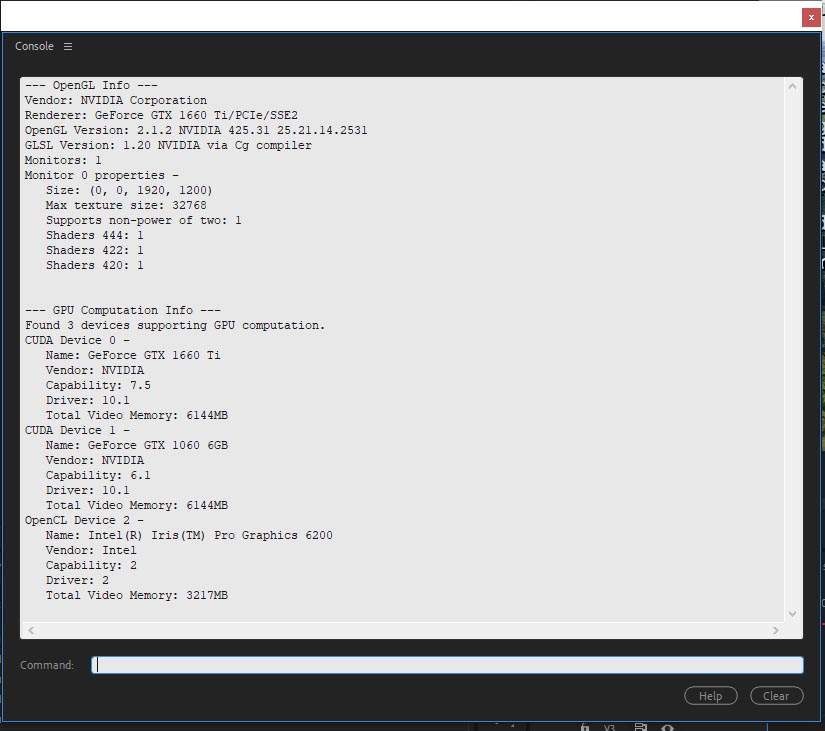

Запускаем программу Adobe Premiere Pro CC 2019 и смотрим с помощью утилиты GPUSniffer, как дискретную и интегрированную видеокарту видит программа.

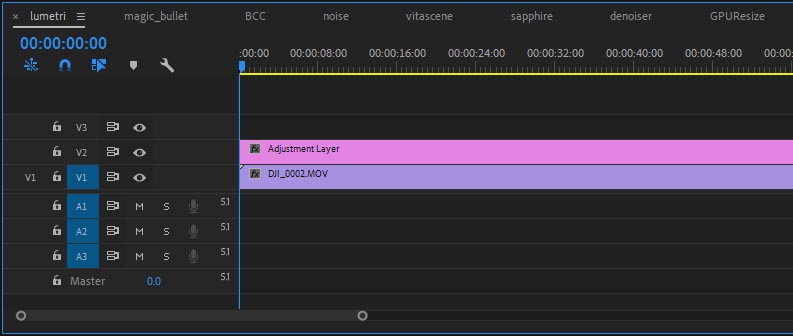

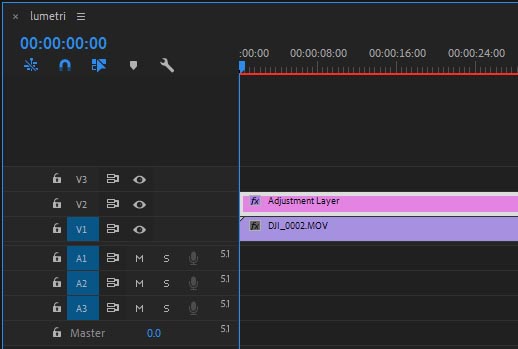

На таймлайне 1 минута 4К видео: UHD (3840x2160p30) H.264 Long-GOP видео, на второй трек добавляем регулирующий слой и растягиваем его на всю длительность клипа:

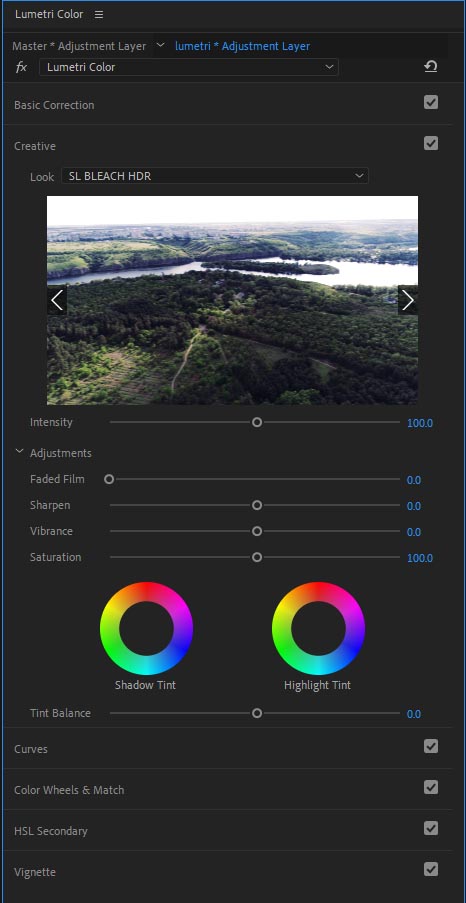

Выделяем регулирующий слой и в панели Lumetri Color выбираем следующий штатный LUT: Look > SL BLEACH HDR.

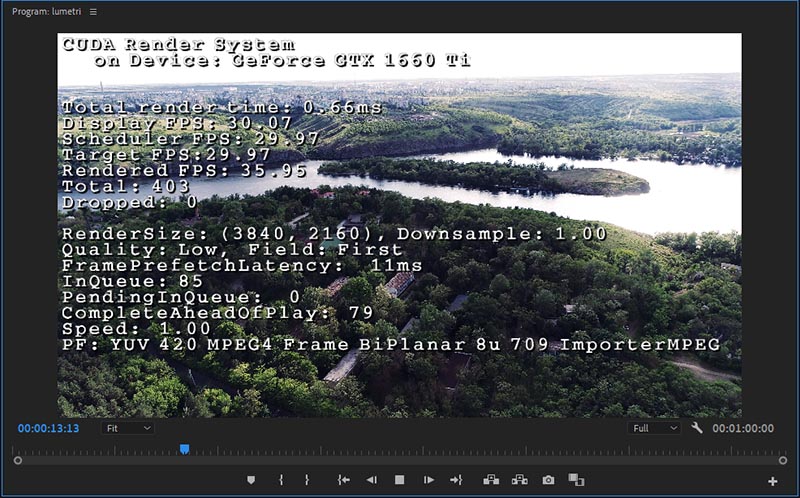

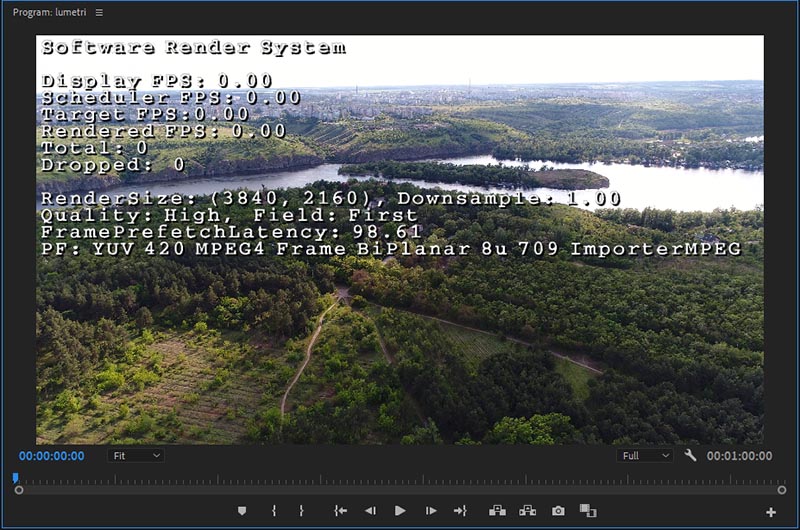

При воспроизведении UHD H.264 Long-GOP видео, информация отображаемая EnableDogEars (Ctrl+Shift+F11). В окне Программа, PF: YUV 420 MPEG4 Frame BiPlanar 8u 709 ImporterMPEG.

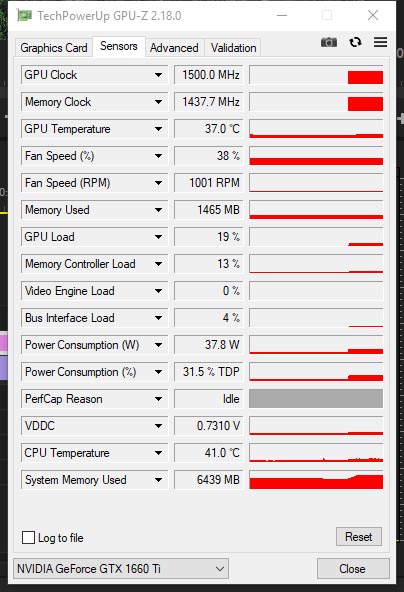

Воспроизведение таймлайна видеокартой Palit GeForce GTX 1660 Ti StormX OC, загрузка GPU - 19%, при тактовой частоте 1.5ГГц.

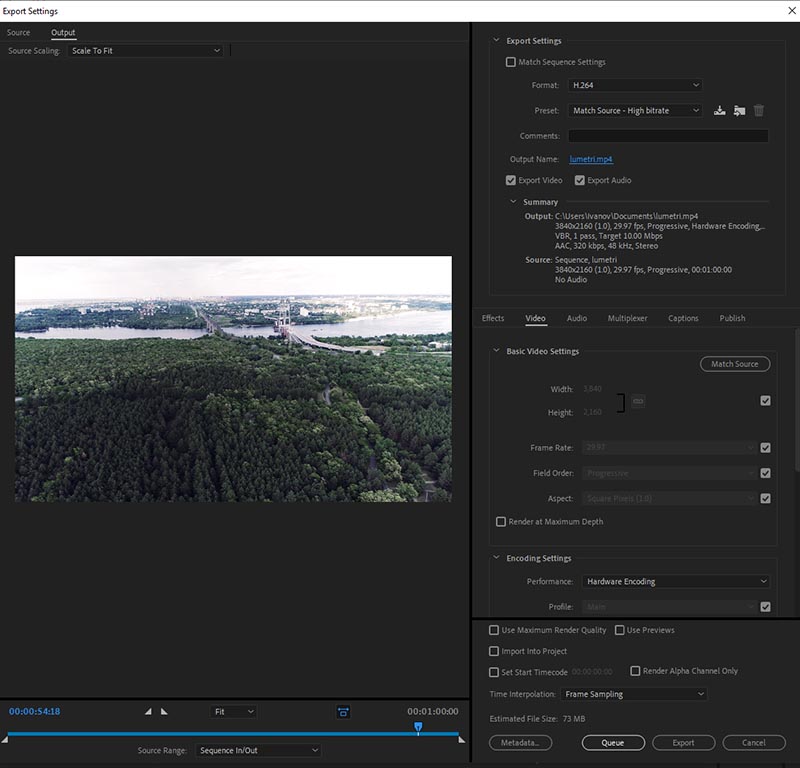

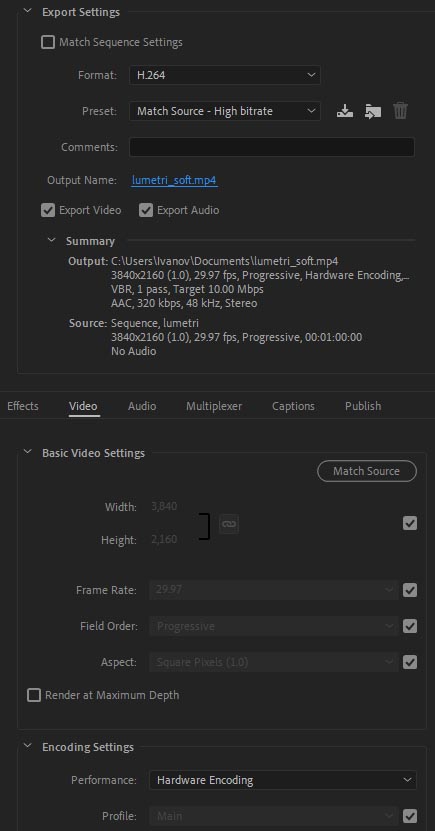

Ctrl+M и в настройках экспорта, выбираем формат: H.264 и пресет Match Source - High bitrate. По-умолчанию активировано iGPU аппаратное декодирование и кодирование (Encoding Settings > Performance: Hardware Encoding) с помощью iGPU.

Нажимаем на кнопку: Export.

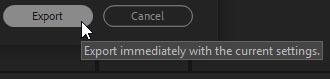

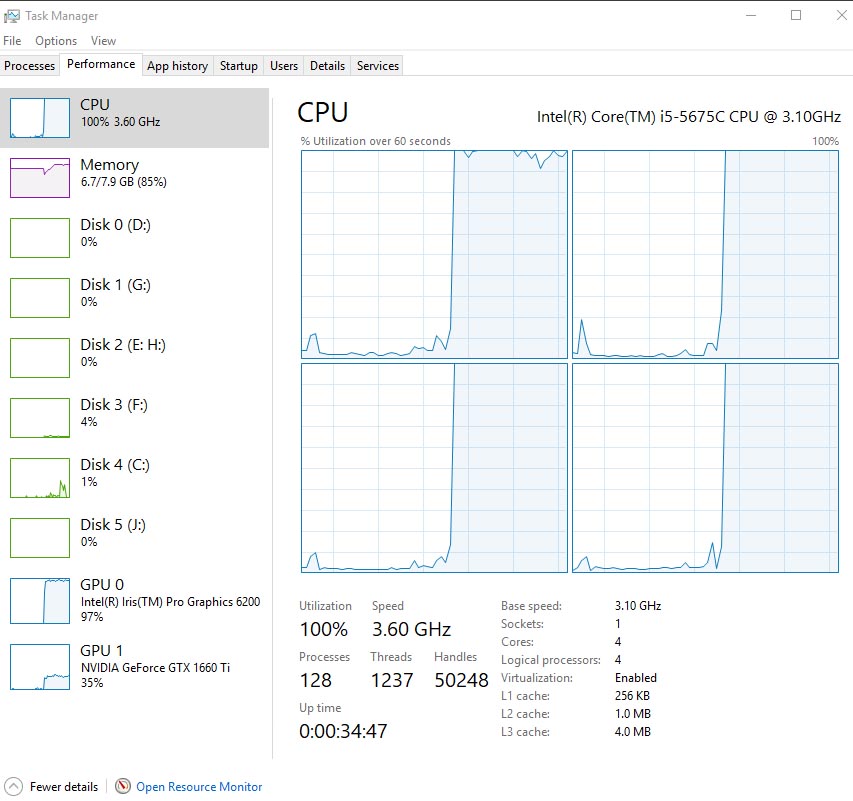

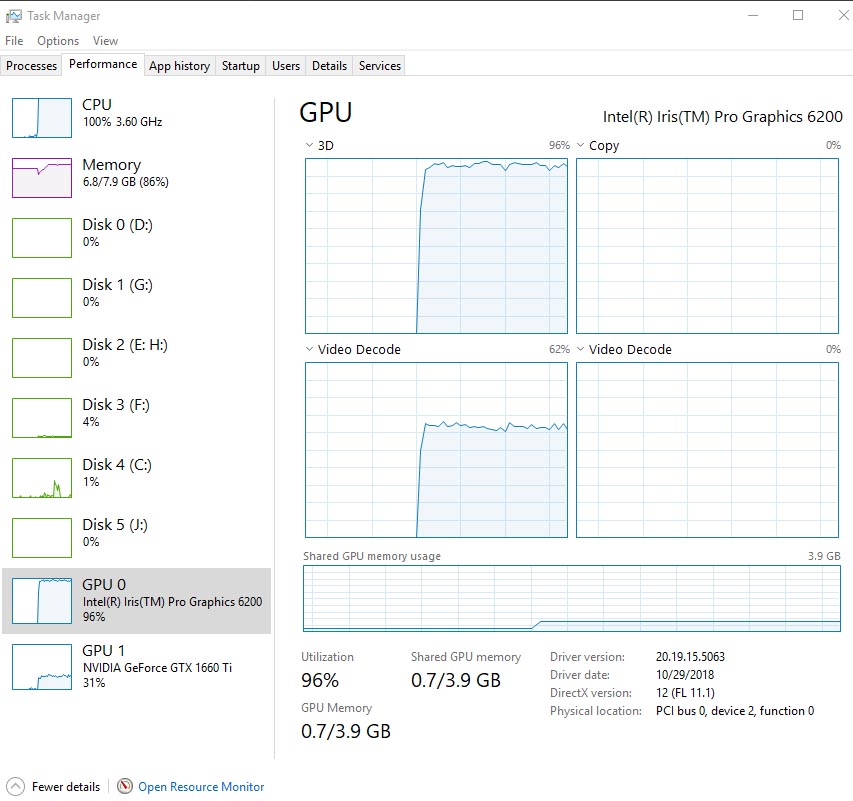

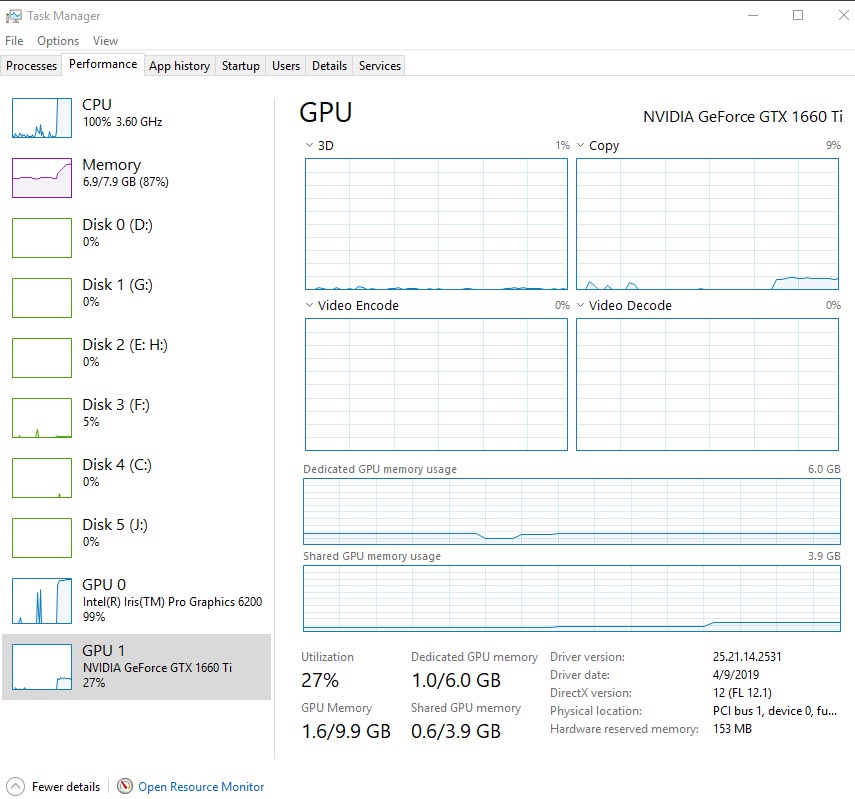

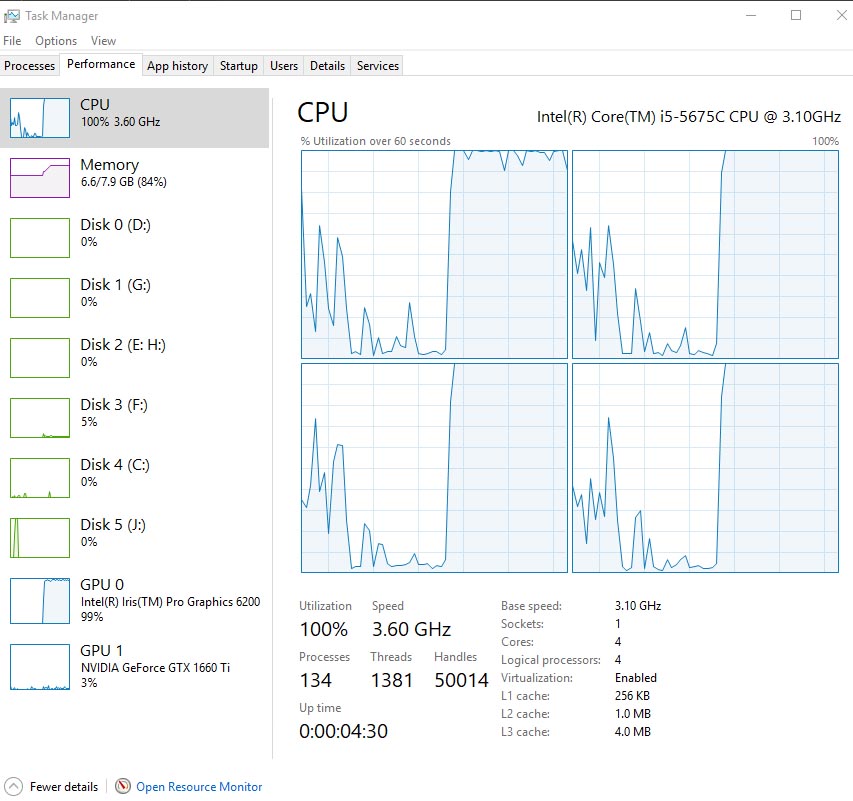

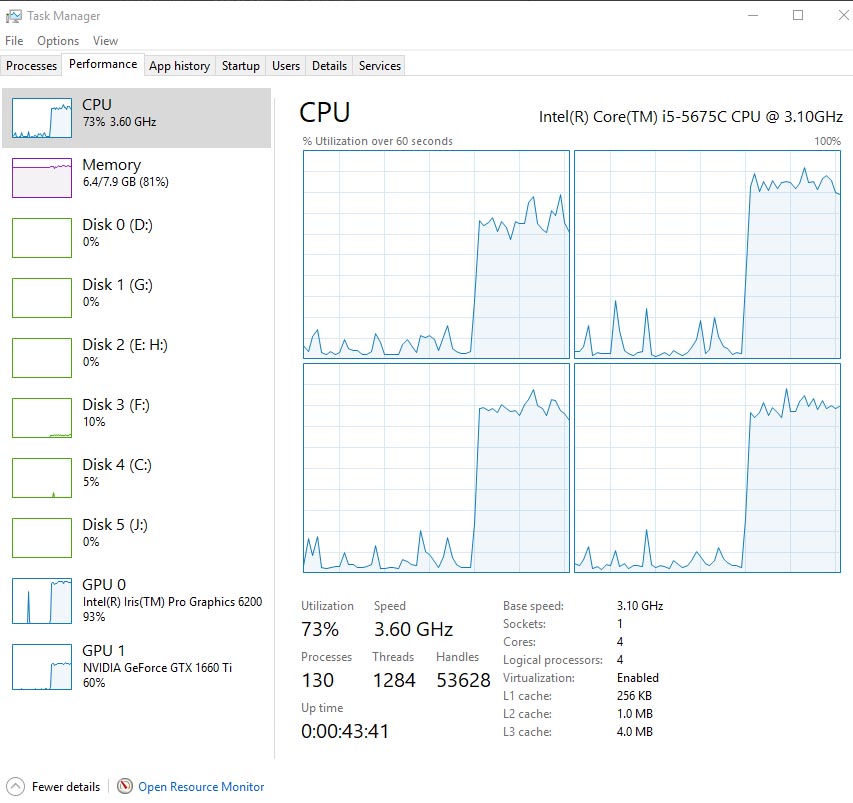

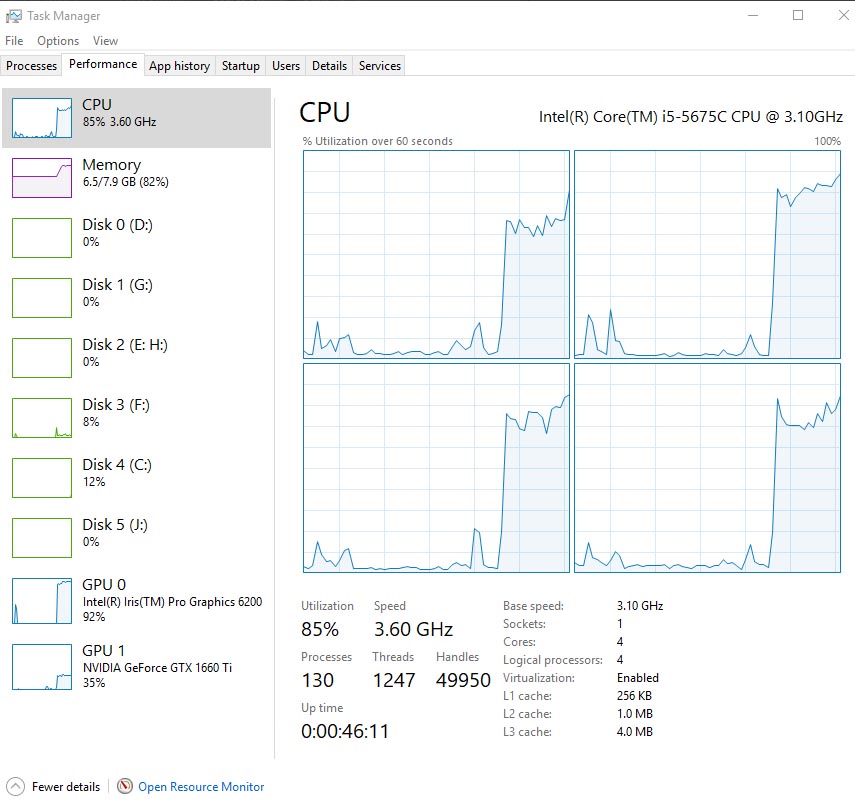

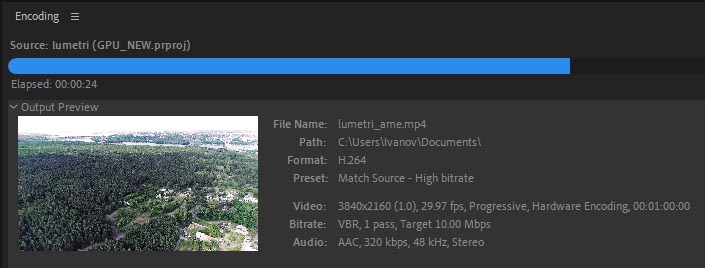

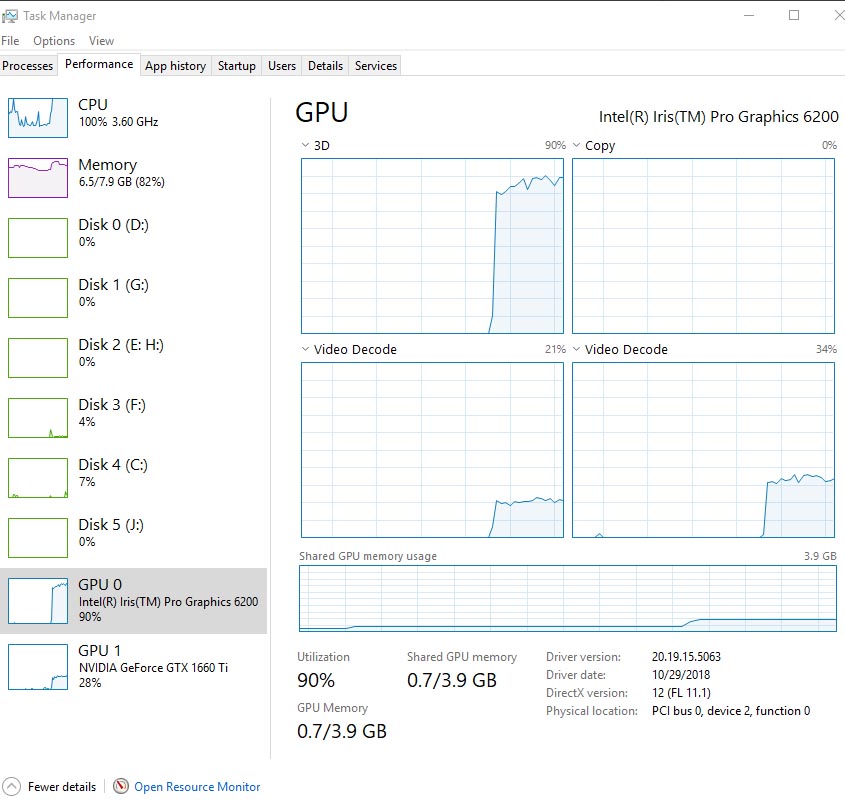

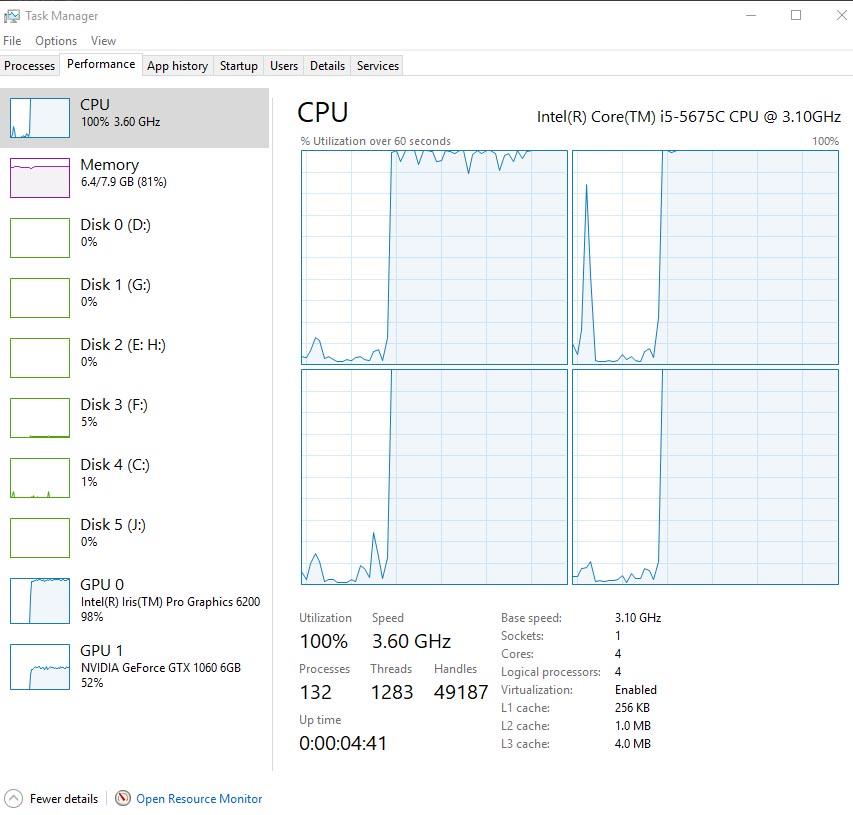

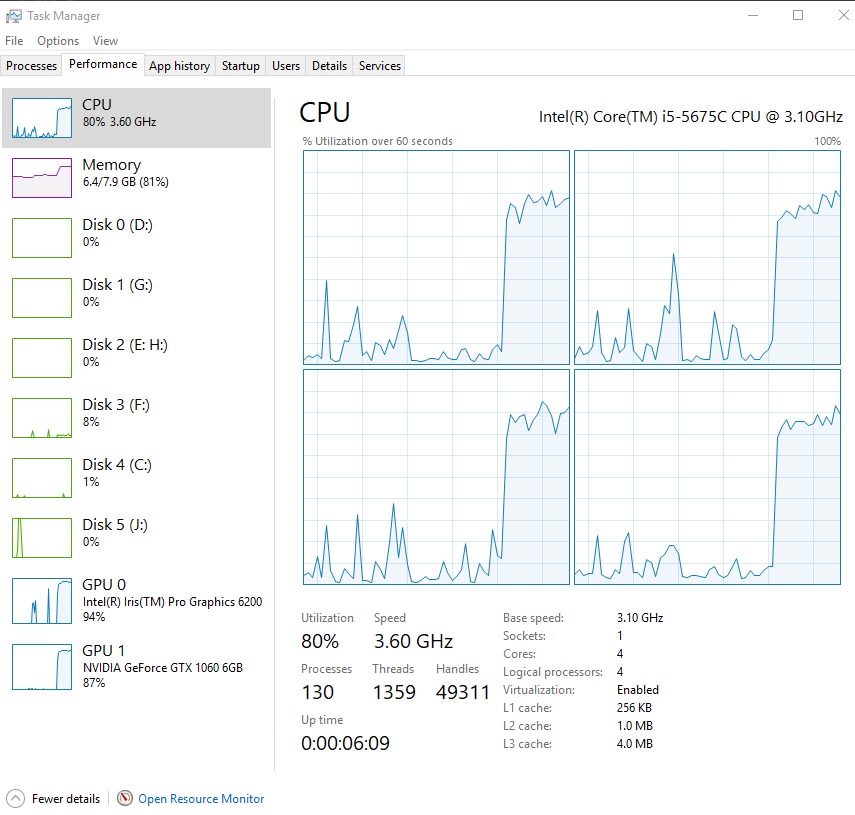

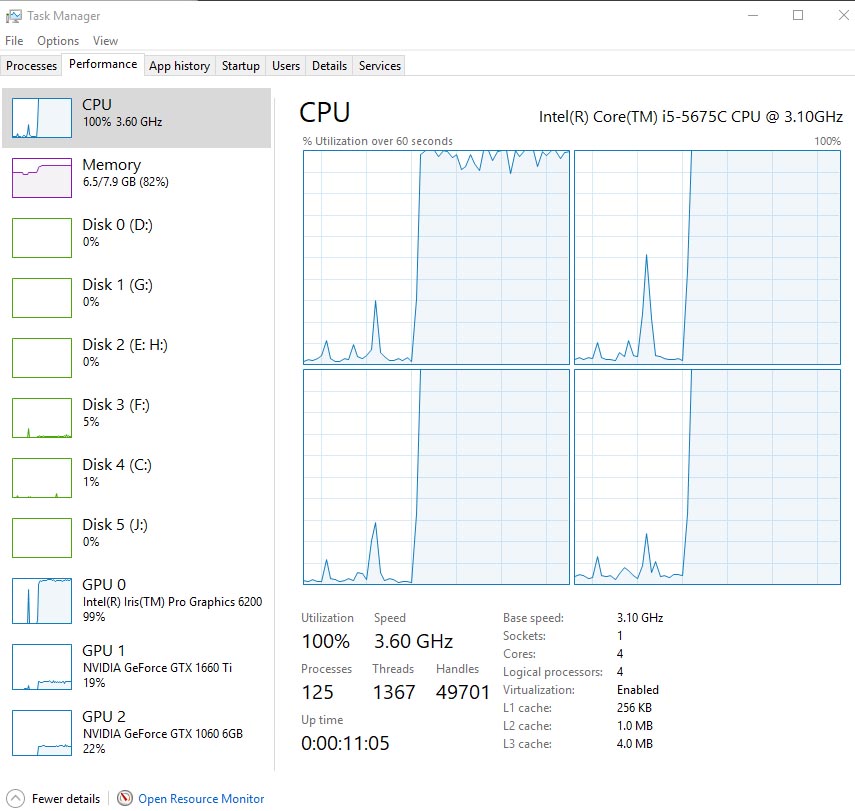

Загрузка четырёхъядерного процессора Intel Core i5-5675C: 100% (при тактовой частоте 3.6ГГц), аппаратное декодирование и кодирование производилось с помощью Intel Iris Pro Graphics 6200.

Загрузка Intel Iris Pro Graphics 6200: 96%.

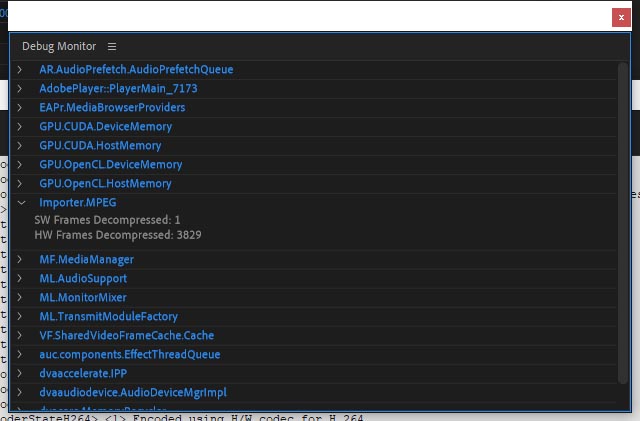

В панели Debug Monitor (Ctrl+Alt+F12) в закладке ImporterMPEG видим, что за декодирование видео отвечает iGPU, бежит счётчик напротив пункта HW Frames Decompressed:

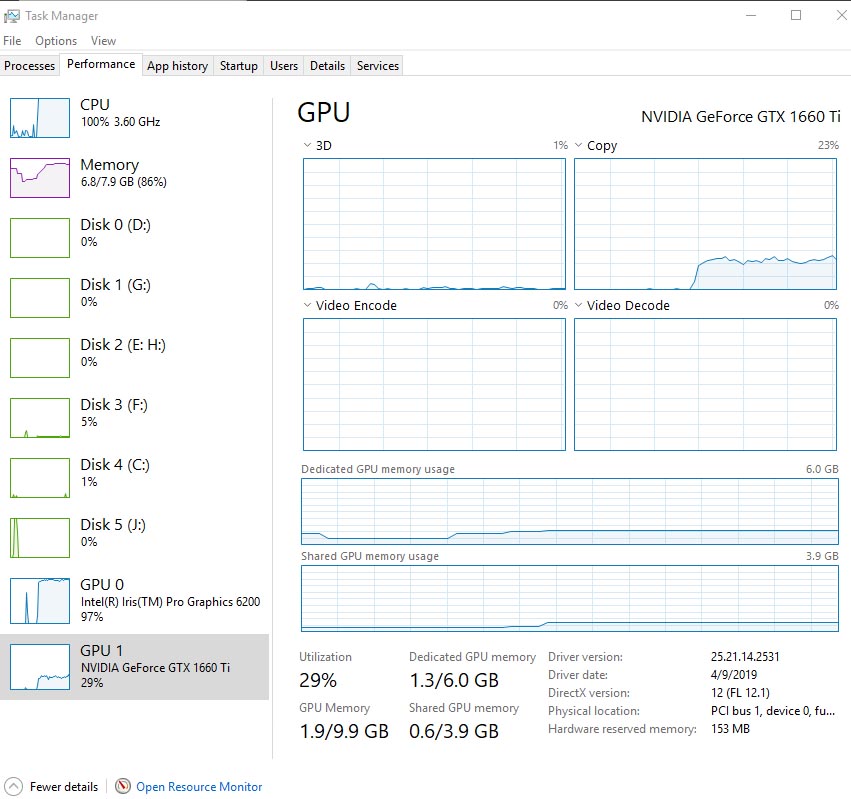

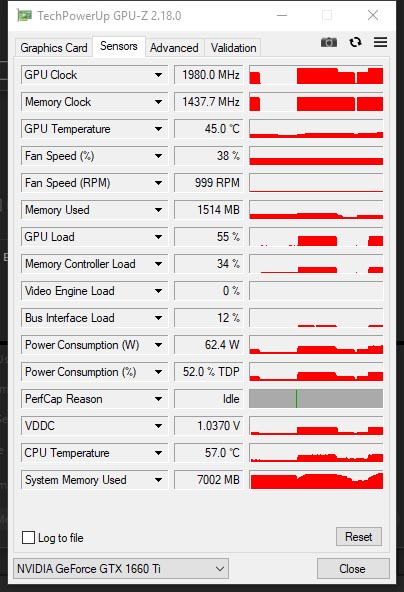

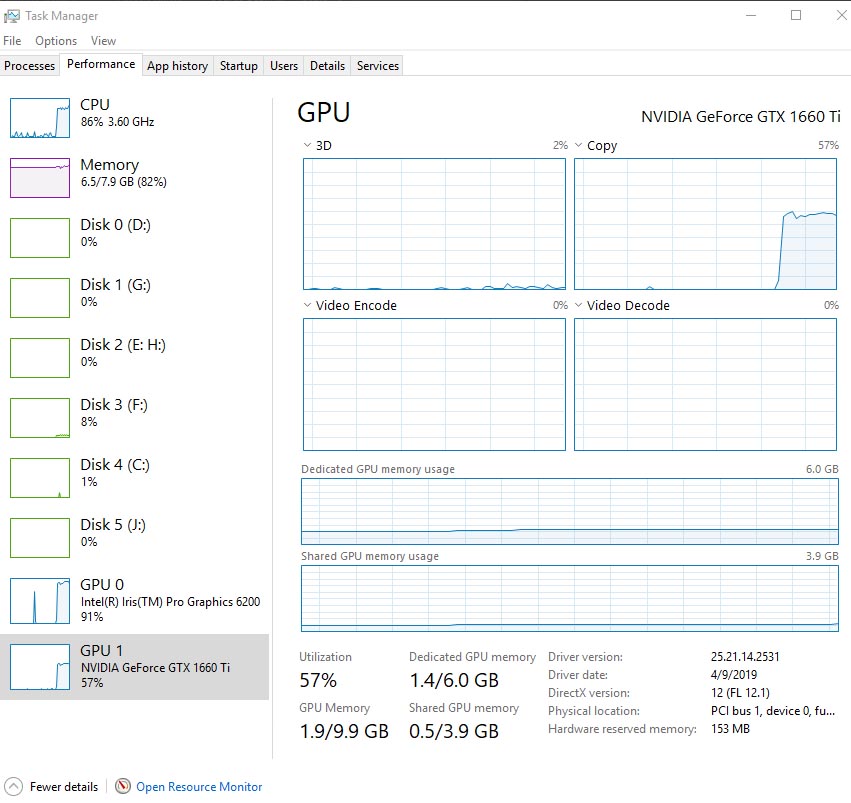

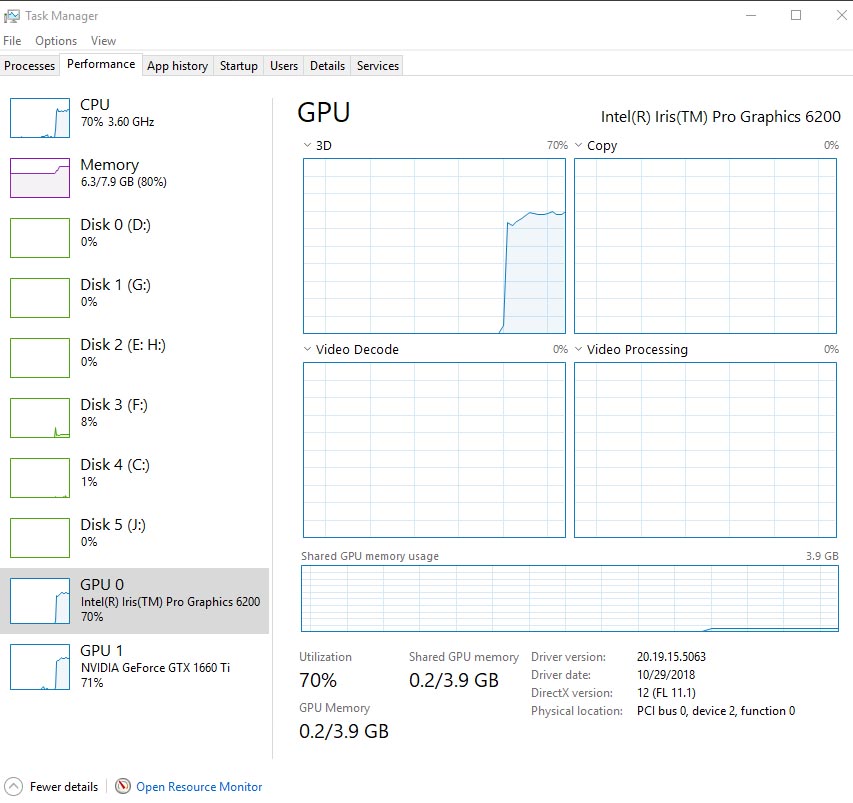

Диспетчер задач на операционной системе Windows 10 Enterprise 2019 LTSC x64 en-US February 2019 Version 1809 Build 17763.348 не всегда точно показывает загрузку дискретной видеокарты.

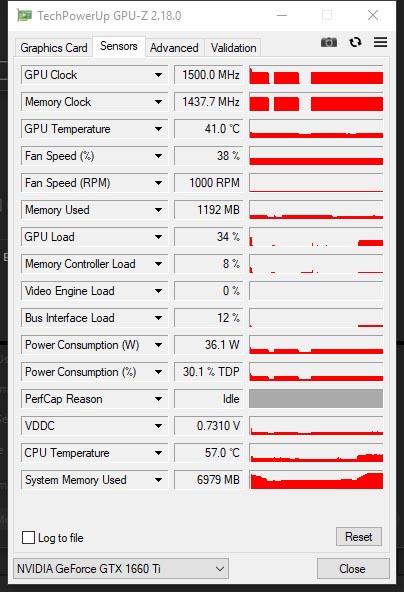

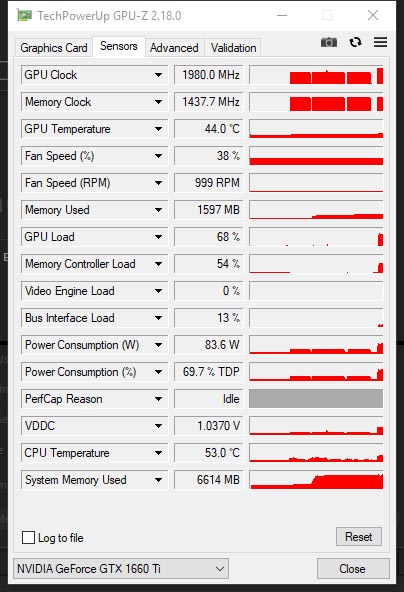

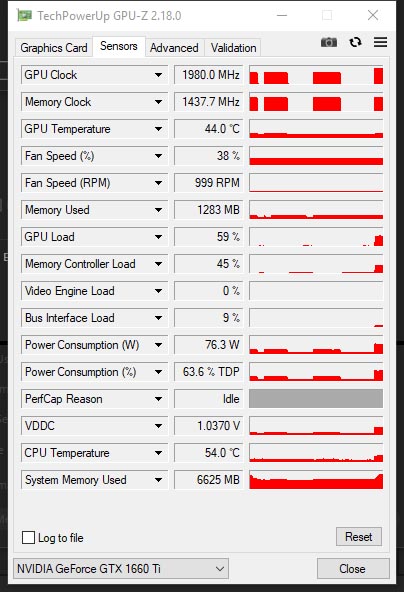

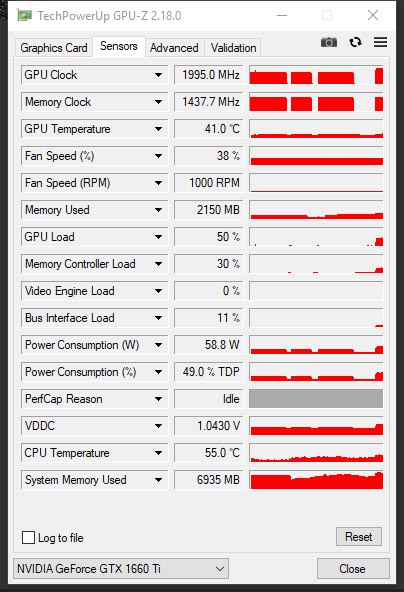

Поэтому используем утилиту GPU-Z для определения степени загрузки видеокарты. GPU дискретной карточки Palit GeForce GTX 1660 Ti StormX OC работал на частоте 1980МГц, утилизировано было 1514Мб видеопамяти (для 4K@30p), загрузка GPU - 55%.

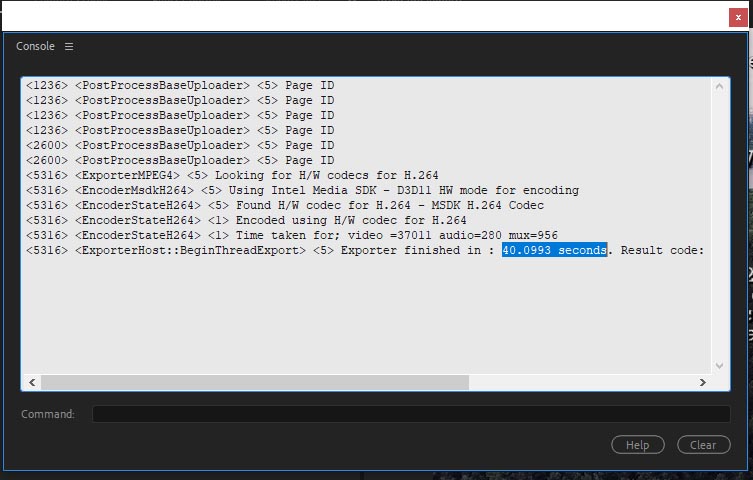

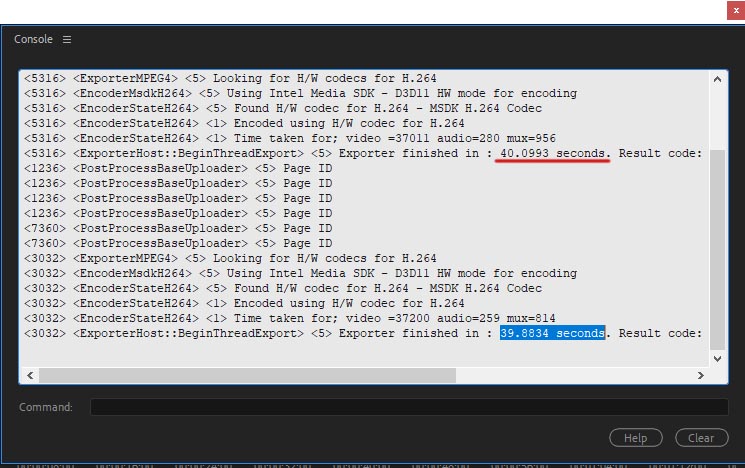

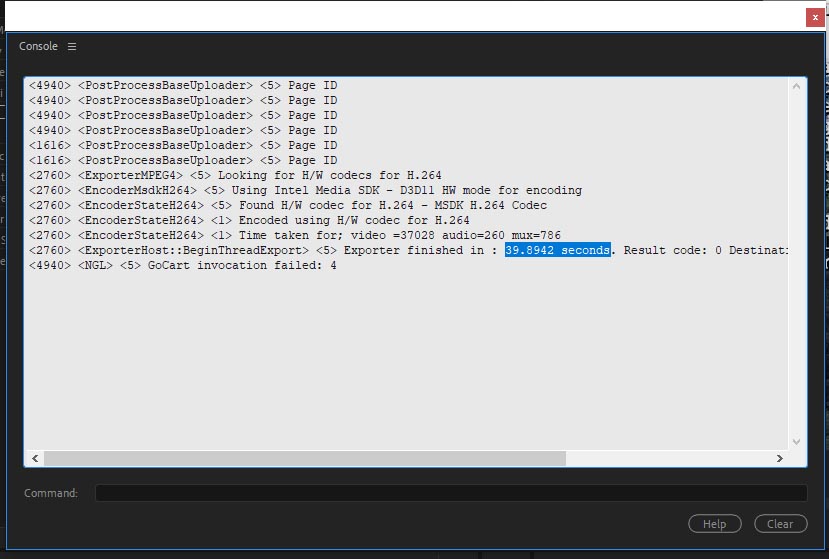

Итоговое время рендеринга: 40 секунд.

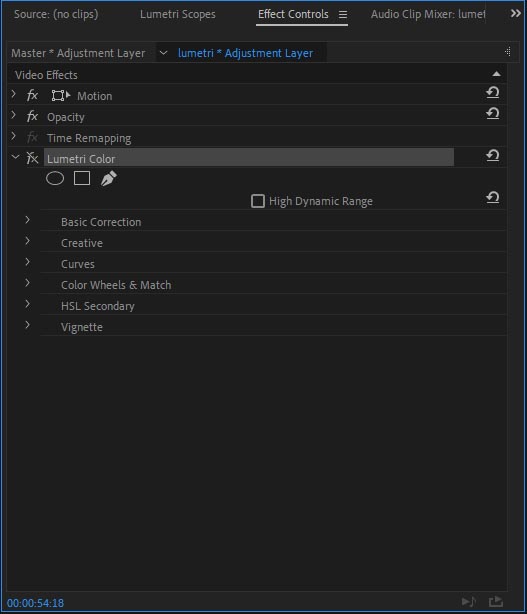

В панели: Элементы управления эффектами (Effect Controls) отключаем эффект Lumetri Color.

Загрузка при рендеринге: CPU - 100% и iGPU - 99%.

Загрузка GPU дискретной карточки Palit GeForce GTX 1660 Ti StormX OC - 34%, при тактовой рабочей частоте 1.5ГГц.

Итоговое время рендеринга: 40 секунд. Как не трудно догадаться, все упирается в скорость кодирования аппаратного движка Intel Quick Sync Video. Т.е. меняя видеокарты, можно получить время только больше, меньше нельзя, так как всё упирается в то, что iGPU не может кодировать видео быстрее 40 секунд.

Чтобы получить время в 2 раза быстрее, надо чтобы QSV работал в 2 раза быстрее, но это не имеет никакого отношения к выбору и тестированию дискретных видеокарт.

И для современных видеокарт эта задача очень простая, соответственно если кто-то бы захотел увидеть разницу между моделями одного производителя, или разницу между AMD vs NVIDIA, получил бы везде эти 40 секунд.

Ещё раз, если на Mac OS движок QSV может справиться с этой задачей за 20 секунд, т.е. мы теоретически получили бы время в 2 раза меньше, но причём тут AMD vs NVIDIA? В этом и проблема сравнений аля "мягкое vs холодное".

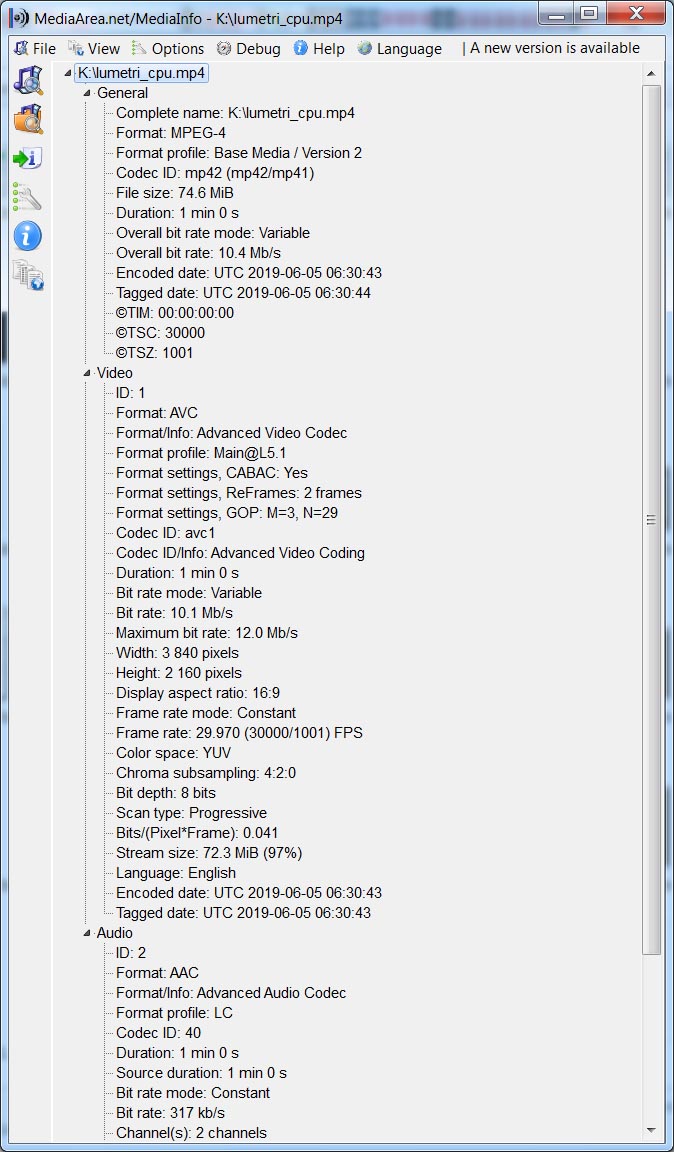

Характеристики файла полученного на выходе:

Зоркий читатель, скорее всего не пропустил тот момент, что при отключении эффекта Lumetri Color, мы всё равно получили загрузку дискретной видеокарты на уровне 34% (@1.5ГГц). Чем она занималась?

Очень хороший вопрос, чем занимается дискретная видеокарта, когда для неё нет "видимой" работы. Но, это вопрос к адобовским инженерам.

Эта "проблема" не возникла вчера и не имеет отношение только к данной версии программы. Ещё тестируя видеокарту nVidia GeForce GT 1030 (а это более производительный аналог основной мобильной видеокарты nVidia GeForce MX150 для ультрабуков) и скорость работы M.2 накопителей, данный бюджетный чипсет грузился на 100%, и был узким местом. Чтобы обойти это узкое место, приходилось переключаться на движок: Только программное ускорение ядра Mercury Playback.

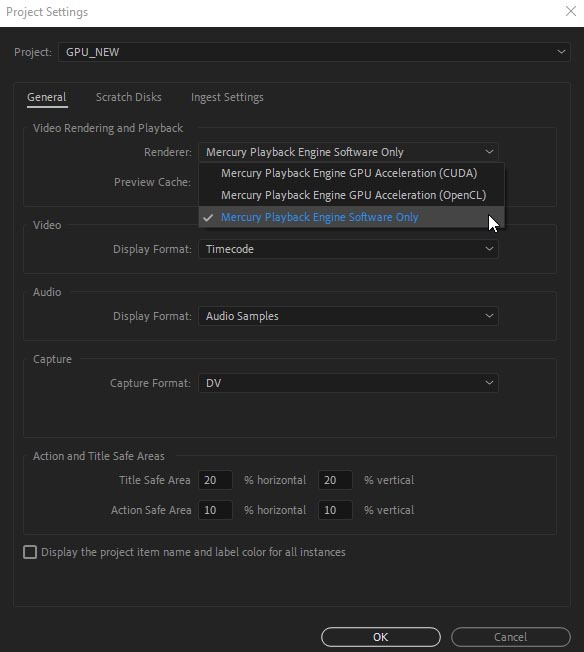

Поэтому повторим результат теста только с софтовым движком, Общие > Рендеринг и воспроизведение видео > Средство рендеринга: Только программное ускорение ядра Mercury Playback.

На таймлайне получаем красную полосу:

В окне Программа. Software Render System. PF: YUV 420 MPEG4 Frame BiPlanar 8u 709 ImporterMPEG.

Настройки экспорта:

Загрузка при рендеринге: CPU - 100% и iGPU - 99%.

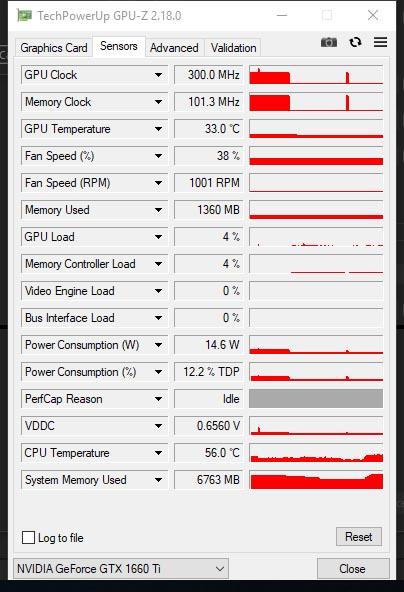

Загрузка дискретной видеокарты: 4% (@300МГц).

Итоговое время, всё тоже ~ 40 секунд.

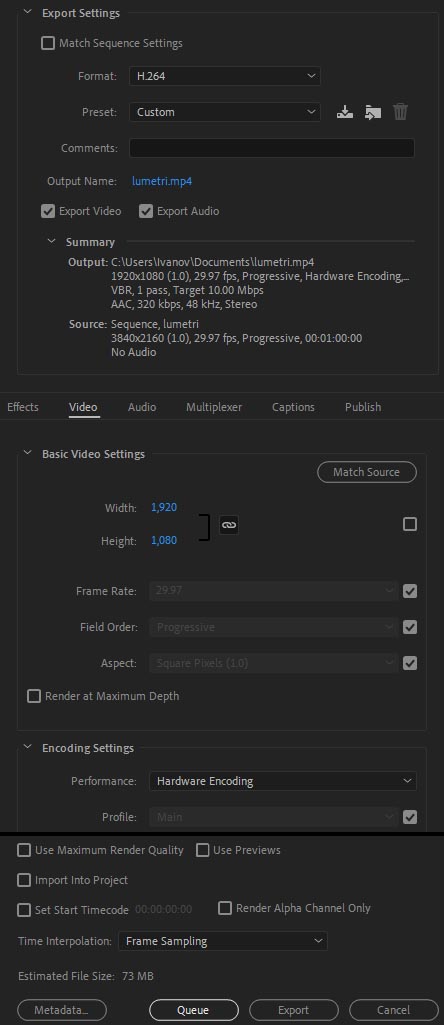

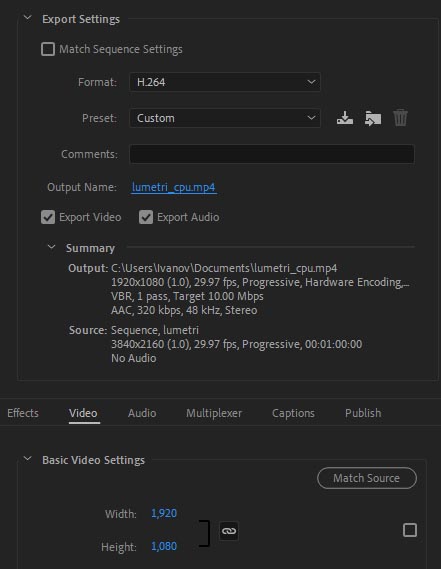

А компот? А как же скалинг. Те же настройки экспорта, только изменяем разрешение на 1920х1080 (пресет автоматически меняется на Custom). Выводим таймлайн с включённым эффектом Lumetri Color.

Загрузка при рендеринге: CPU - 73% и iGPU - 93%.

Диспетчер задач показывает загрузку дискретной видеокарты:

Загрузка GPU дискретной карточки Palit GeForce GTX 1660 Ti StormX OC - 68%, при тактовой рабочей частоте 1980МГц.

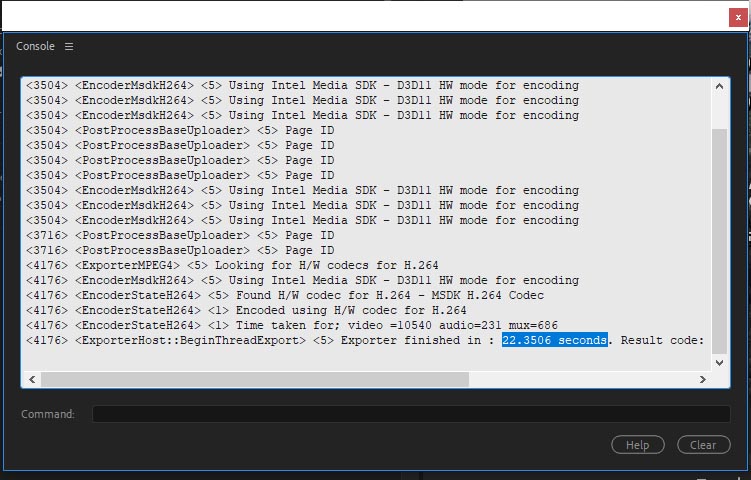

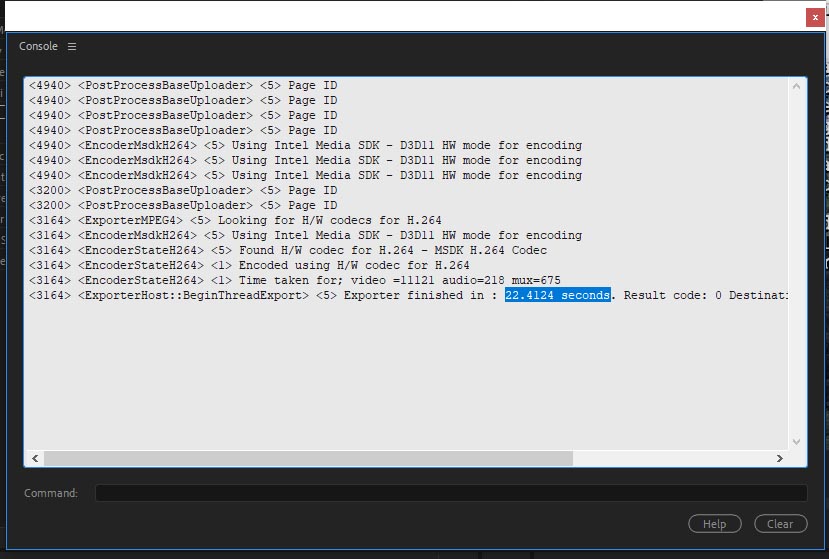

Итоговое время рендеринга: 22 секунды.

Те же настройки, но отключен эффект Lumetri Color.

Загрузка при рендеринге: CPU - 85% и iGPU - 92%.

Рендеринг видеокартой Palit GeForce GTX 1660 Ti StormX OC, загрузка GPU - 59%, при тактовой частоте 1.98ГГц.

Итоговое время рендеринга те же: 22 секунды.

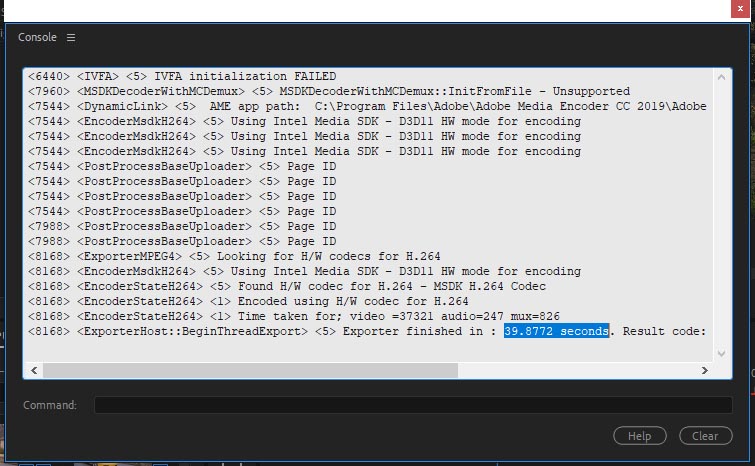

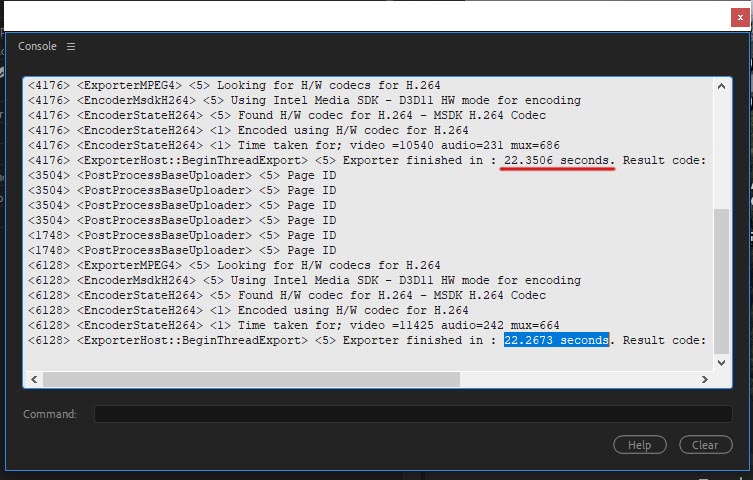

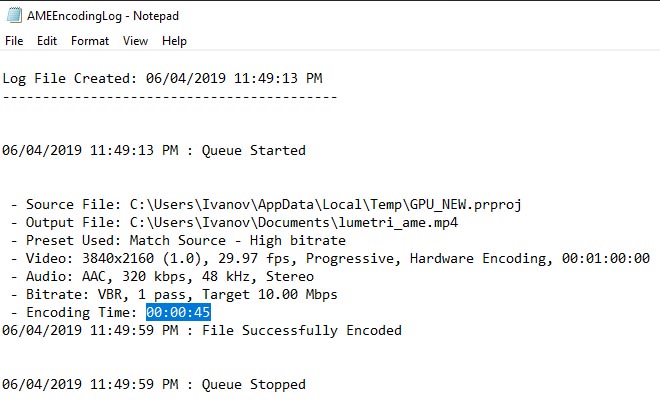

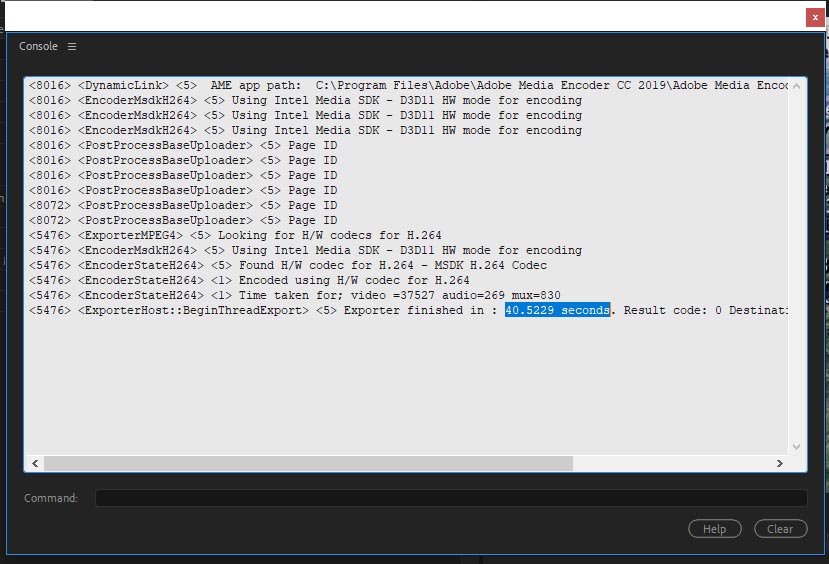

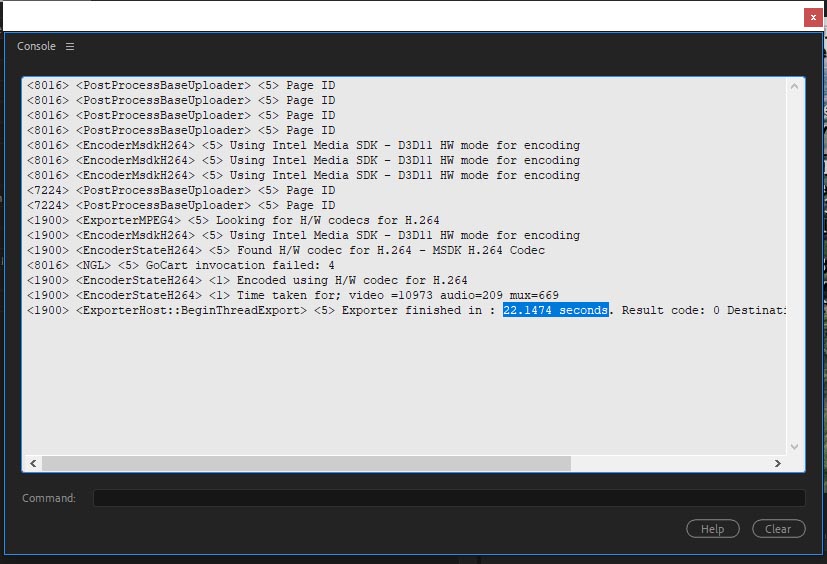

Теперь попробуем вывести проект (без скалинга) с помощью Adobe Media Encoder CC 2019, чтобы проверить, что там с LUT на регулирующем слое. Нажимаем на кнопку: Queue.

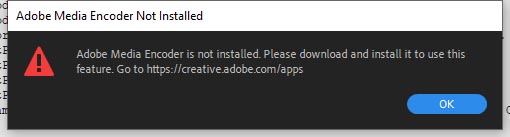

Получаем сообщение, что Adobe Media Encoder CC 2019 не установлен, в системе.

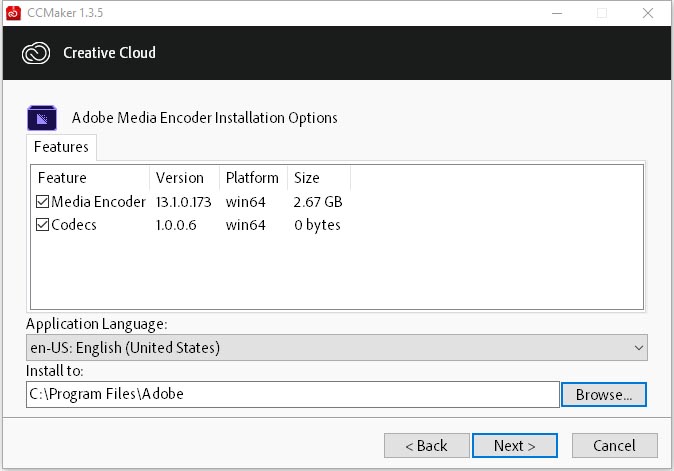

С помощью CCMaker устанавливаем билд Media Encoder v13.1.0.173.

Активируем с помощью инструмента: Adobe CC 2019 - GenP_V1.5.6.1.

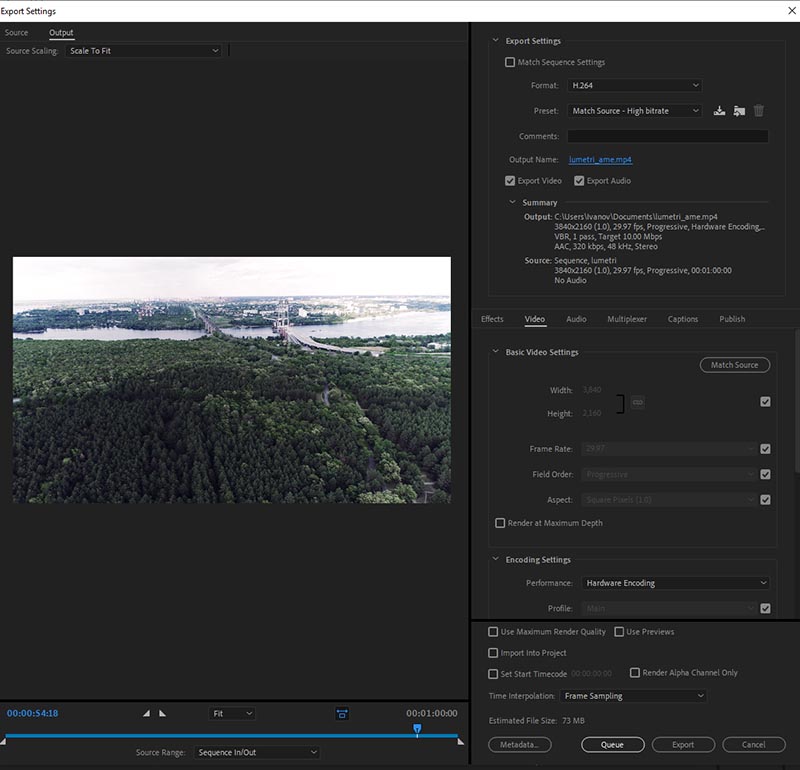

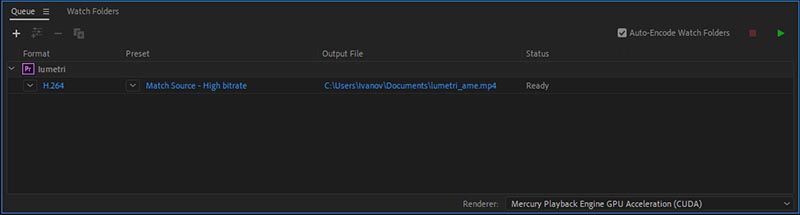

Ctrl+M и в настройках экспорта, выбираем формат: H.264 и пресет Match Source - High bitrate. По-умолчанию активировано iGPU аппаратное декодирование и кодирование (Encoding Settings > Performance: Hardware Encoding) с помощью iGPU.

Нажимаем на кнопку: Queue.

Заставка Adobe Media Encoder CC 2019:

Выбран Renderer: Mercury Playback Engine GPU Acceleration (CUDA).

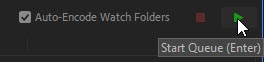

Нажимаем на кнопку: Start Queue (Enter).

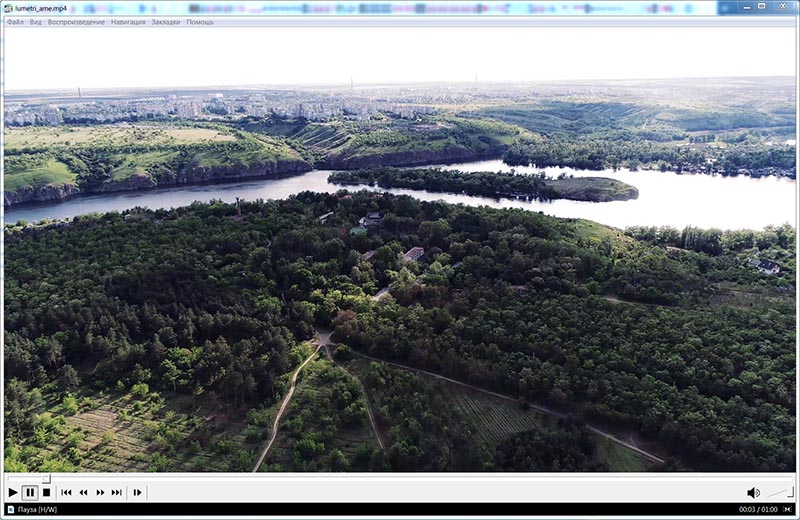

В окне предпросмотра LUT на своём месте:

Загрузка при рендеринге: CPU - 100% и iGPU - 91%.

GPU Load (Intel Iris Pro Graphics 6200) - 90%.

Рендеринг таймлайна видеокартой Palit GeForce GTX 1660 Ti StormX OC, загрузка GPU - 50%, при тактовой частоте 1995МГц.

Итоговое время рендеринга из-за "накладных расходов" как правило больше, чем при прямом выводе: 45 секунд.

Картинка после экспорта с применённым LUT. Но, то что программа Adobe Media Encoder может "терять" ряд операций - это не новость, надо быть внимательным и проверять финальный результат.

Теперь прогоним тесты с помощью видеокарты Palit GeForce GTX 1060 Super JetStream (NE51060S15J9-1060J):

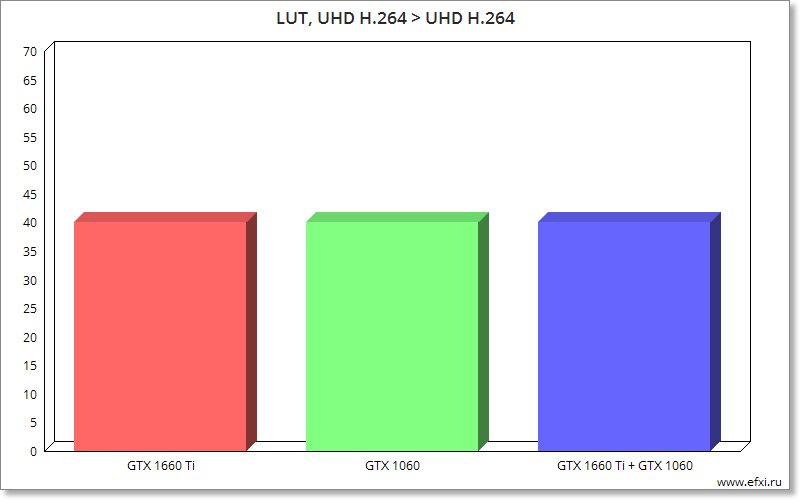

LUT, UHD H.264 > UHD H.264 Match Source - High Bitrate. Загрузка, CPU - 100%, iGPU - 98%, GPU (GeForce GTX 1060) - 52%.

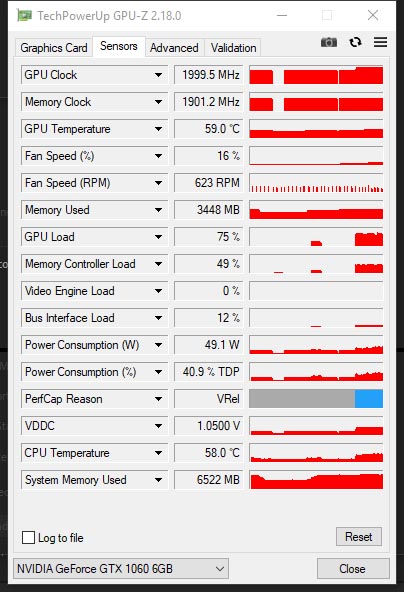

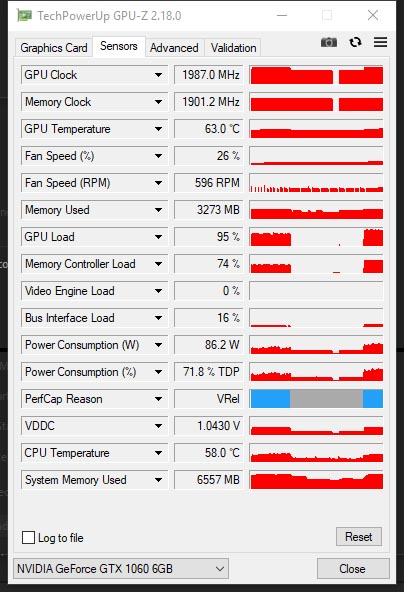

NVIDIA GeForce GTX 1060 6Gb, GPU Load - 75%, тактовая частота - 1999МГц, было утилизировано 3448 Мб видеопамяти GDDR5.

Итоговое время рендеринга: 40 секунд.

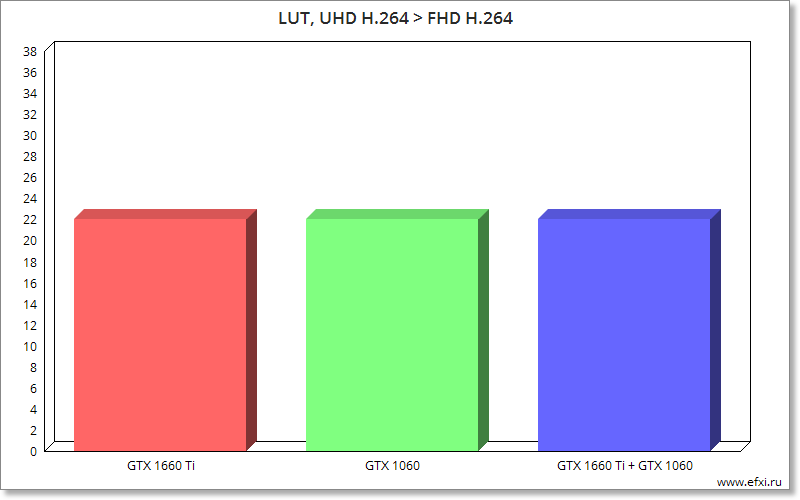

LUT, UHD H.264 > FHD H.264 Match Source - High Bitrate. Загрузка, CPU - 80%, iGPU - 94%, GPU (GeForce GTX 1060) - 87%.

NVIDIA GeForce GTX 1060 6Gb, GPU Load - 95%, тактовая частота - 1987МГц, было утилизировано 3273 Мб видеопамяти GDDR5.

Итоговое время рендеринга: 22 секунды.

Теперь прогоним "тесты" на Multi-GPU связке видеокарт: NVIDIA GeForce GTX 1660 Ti и NVIDIA GeForce GTX 1060 6Gb.

Информация отображаемая утилитой GPUSniffer:

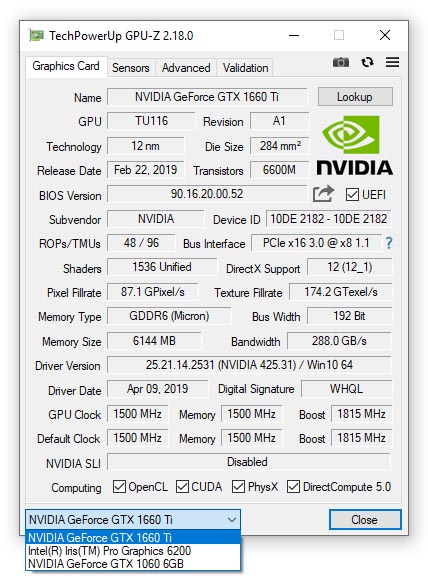

В выпадающем списке утилиты GPU-Z три видеокарты:

LUT, UHD H.264 > UHD H.264 Match Source - High Bitrate. Загрузка, CPU - 100%, iGPU - 99%, GPU (GeForce GTX 1660 Ti/GeForce GTX 1060) - 19/22%.

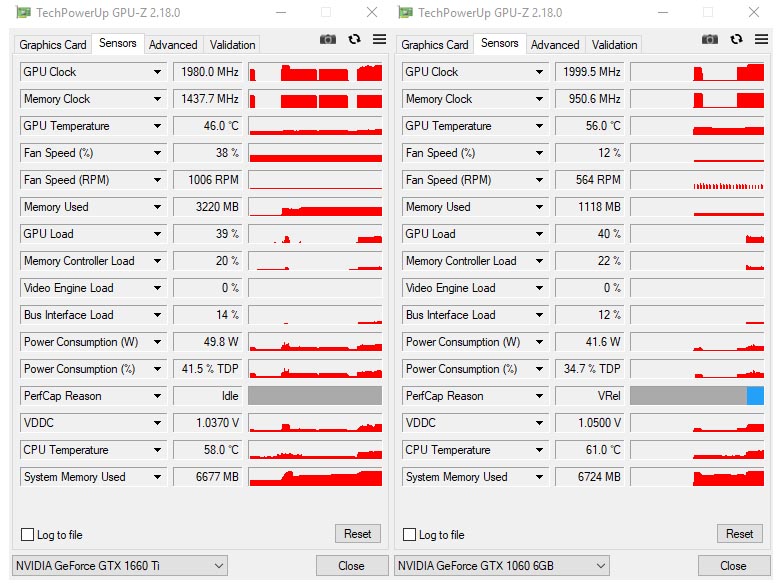

NVIDIA GeForce GTX 1660 Ti, GPU Load - 39%, тактовая частота - 1980МГц, было утилизировано 3220 Мб видеопамяти GDDR6.

NVIDIA GeForce GTX 1060 6Gb, GPU Load - 40%, тактовая частота - 1999МГц, было утилизировано 1118 Мб видеопамяти GDDR5.

Итоговое время рендеринга: 40 секунд.

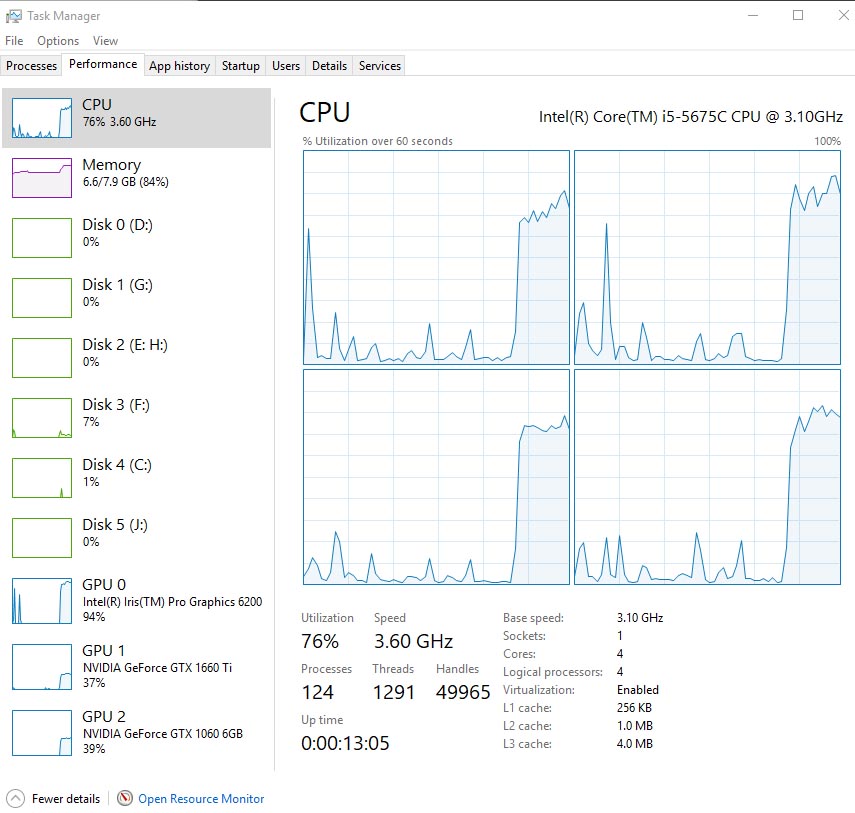

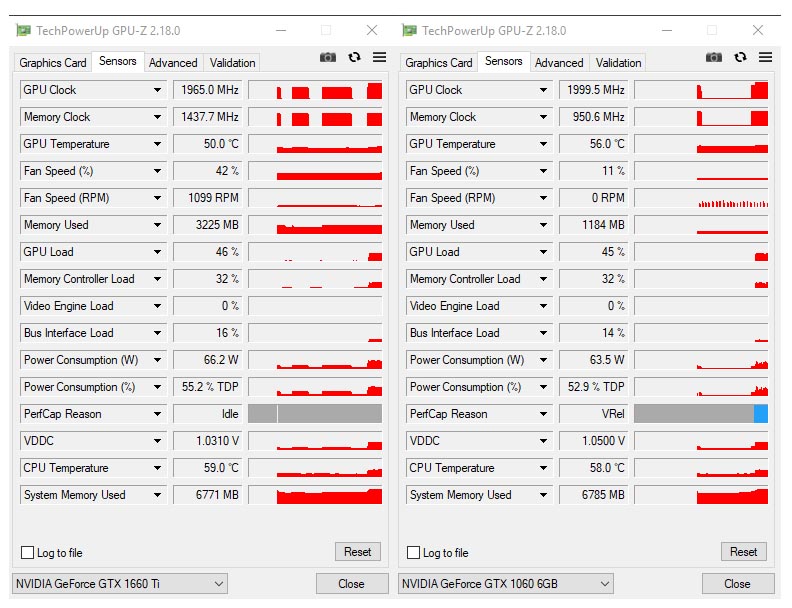

LUT, UHD H.264 > FHD H.264 Match Source - High Bitrate. Загрузка, CPU - 76%, iGPU - 94%, GPU (GeForce GTX 1660 Ti/GeForce GTX 1060) - 37/39%.

NVIDIA GeForce GTX 1660 Ti, GPU Load - 46%, тактовая частота - 1965МГц, было утилизировано 3225 Мб видеопамяти GDDR6.

NVIDIA GeForce GTX 1060 6Gb, GPU Load - 45%, тактовая частота - 1999МГц, было утилизировано 1184 Мб видеопамяти GDDR5.

Итоговое время рендеринга: 22 секунды.

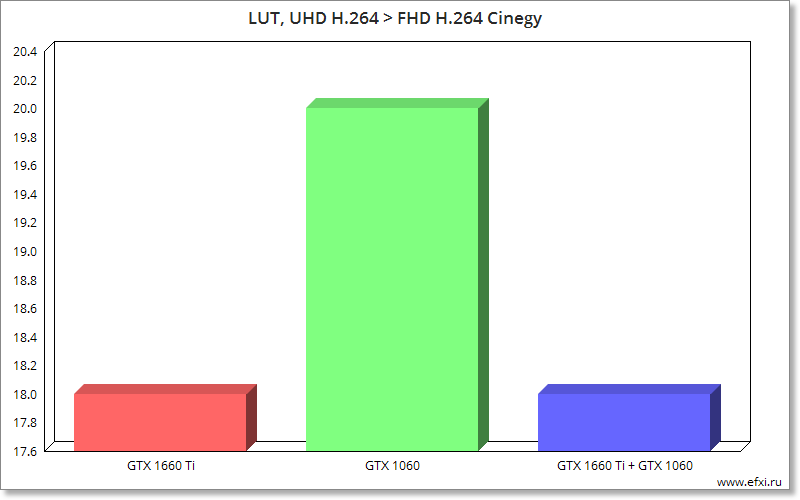

Итоговые результаты сведены в графики:

Кому нужно подобное тестирование? Что можно понять по этим результатам? То, что "узкое место" тут не видеокарта. Поэтому и используются тяжёлые GPU задачи для тестирования разных видеокарт, и если "узким местом" является видеокарта, то видна будет разница именно между GPU.

Будет ли использоваться в работе эти тяжёлые задачи, это уже другой вопрос.

Чтобы получить из этих "тестов" хоть какой-то толк, необходимо выбирать формат видео или движок который сократит время "чистого рендеринга". Тут сразу возникнут вопросы, а почему эти форматы выбраны или я не пользуюсь этим движком и т.п.

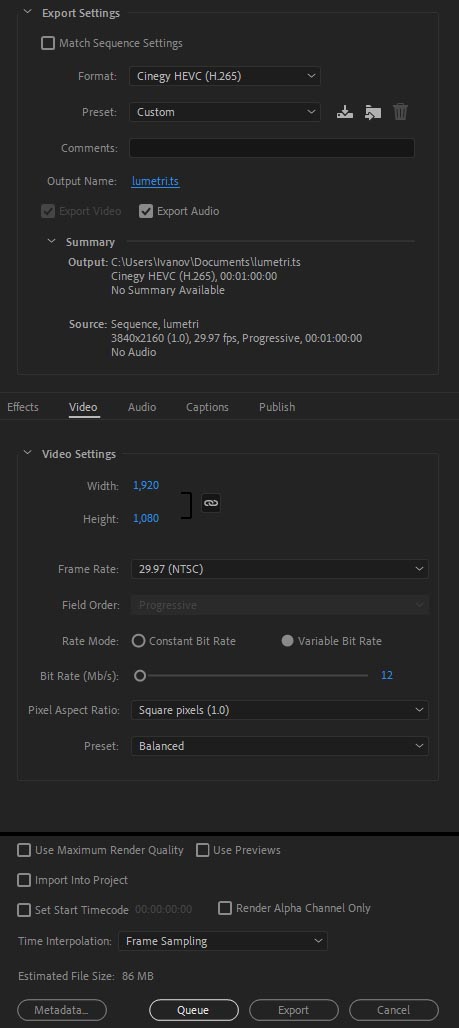

Воспользуемся например одним из самых шустрых аппаратных кодеров: Cinegy Adobe CC 2019 Accelerator Plugin который использует NVIDIA NVENC.

В настройках экспорта выбираем Format: Cinegy HEVC (H.265). Скалинг UHD > FHD.

Palit GeForce GTX 1660 Ti StormX OC. Загрузка в Диспетчере задач, CPU - 70%, iGPU - 70%, GPU (GeForce GTX 1660 Ti) - 71%.

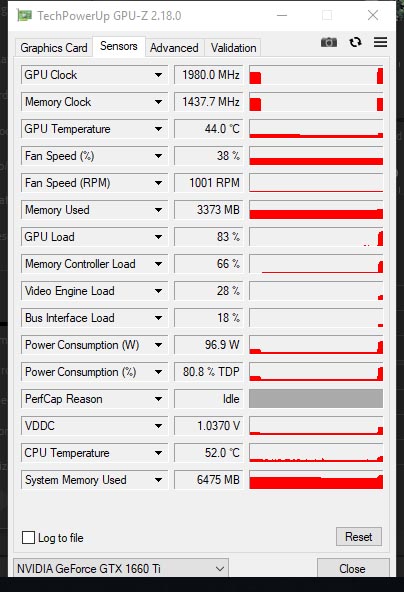

NVIDIA GeForce GTX 1660 Ti, GPU Load - 83%, тактовая частота - 1980МГц, было утилизировано 3373 Мб видеопамяти GDDR6.

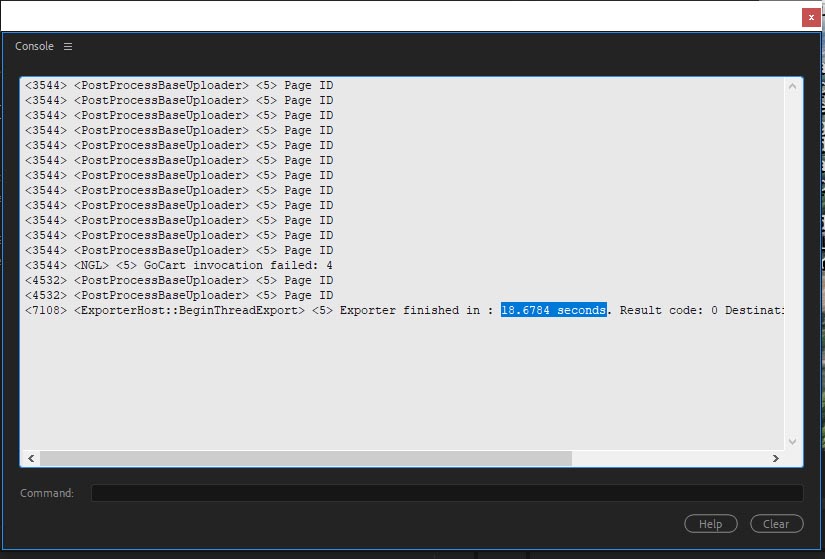

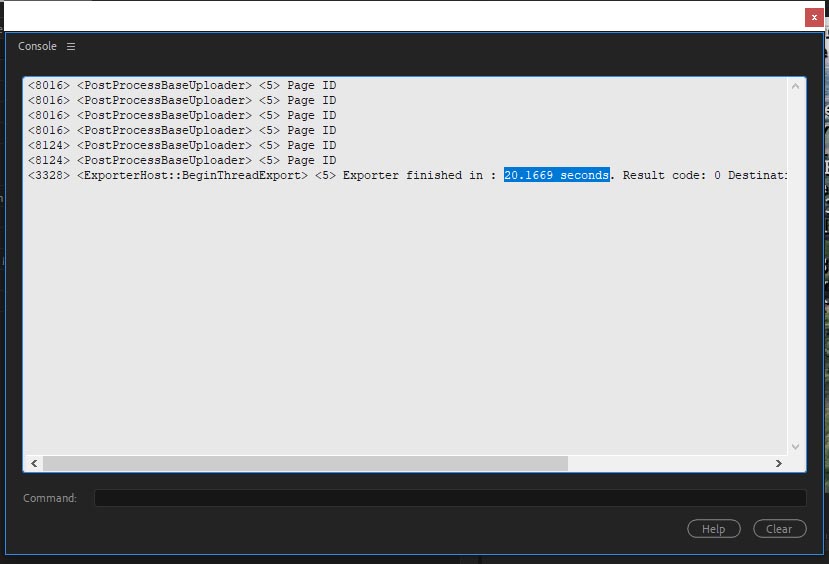

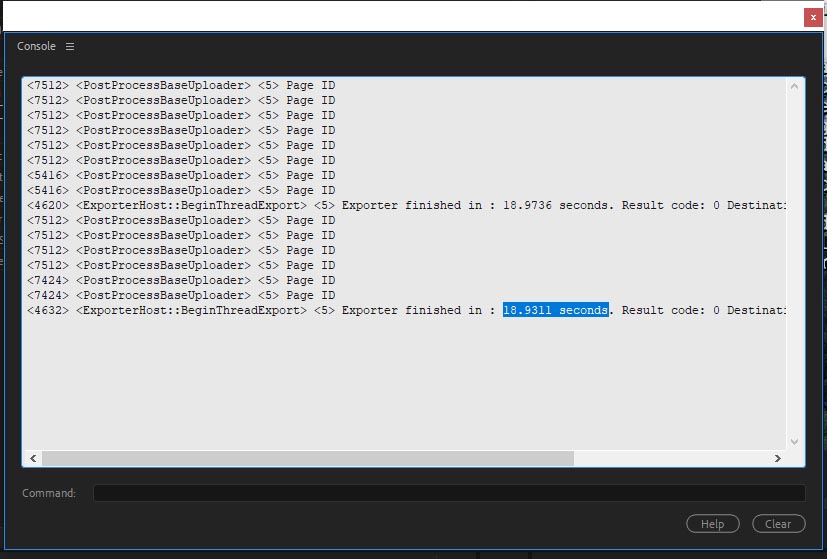

Итоговое время рендеринга: 18 секунд.

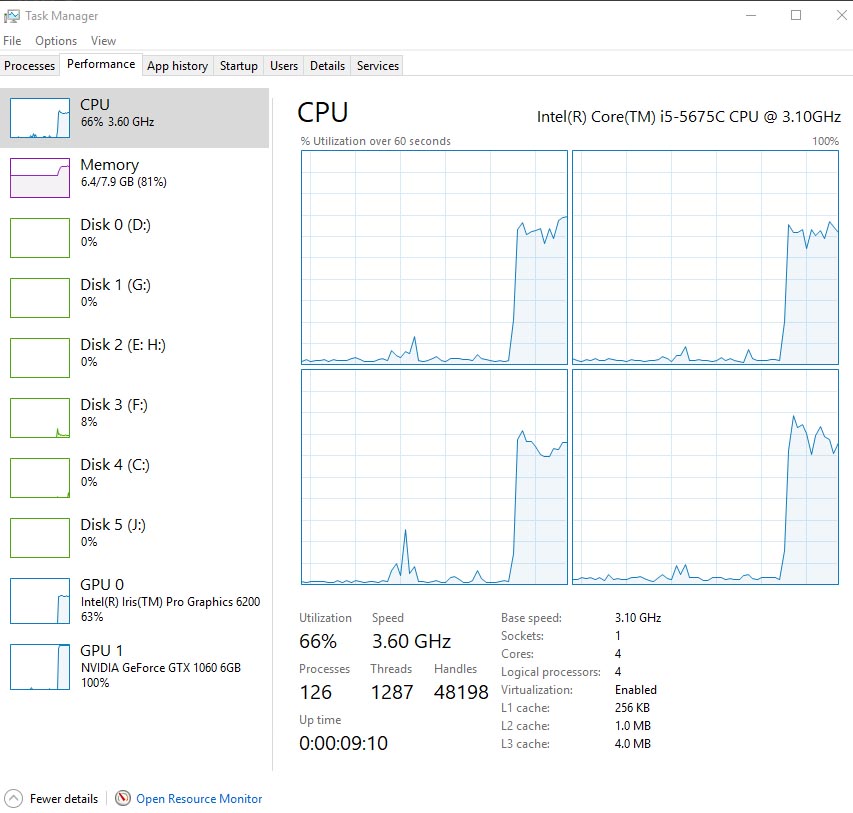

Palit GeForce GTX 1060 Super JetStream. Загрузка в Диспетчере задач, CPU - 66%, iGPU - 63%, GPU (GeForce GTX 1060 6GB) - 100%.

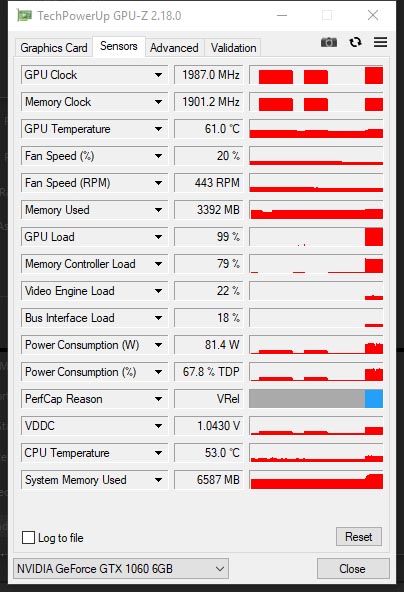

NVIDIA GeForce GTX 1060 6GB, GPU Load - 99%, тактовая частота - 1987МГц, было утилизировано 3392 Мб видеопамяти GDDR5.

Итоговое время рендеринга: 20 секунд.

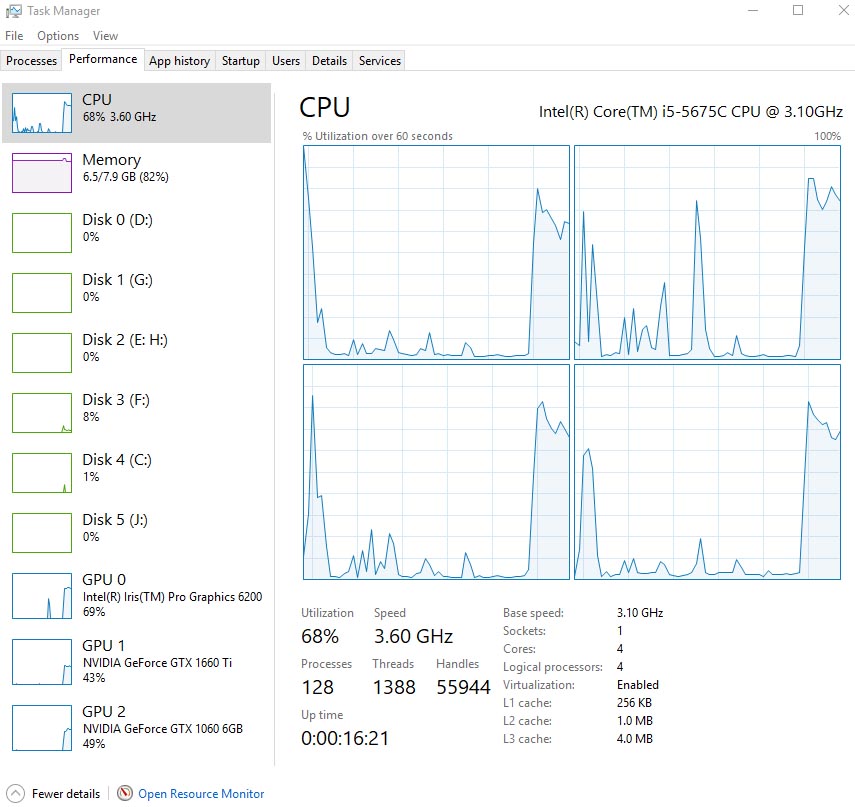

Multi-GPU: Palit GeForce GTX 1660 Ti StormX OC + Palit GeForce GTX 1060 Super JetStream. Загрузка в Диспетчере задач, CPU - 68%, iGPU - 69%, GPU (GeForce GTX 1660 Ti/GeForce GTX 1060 6GB) - 43/49%.

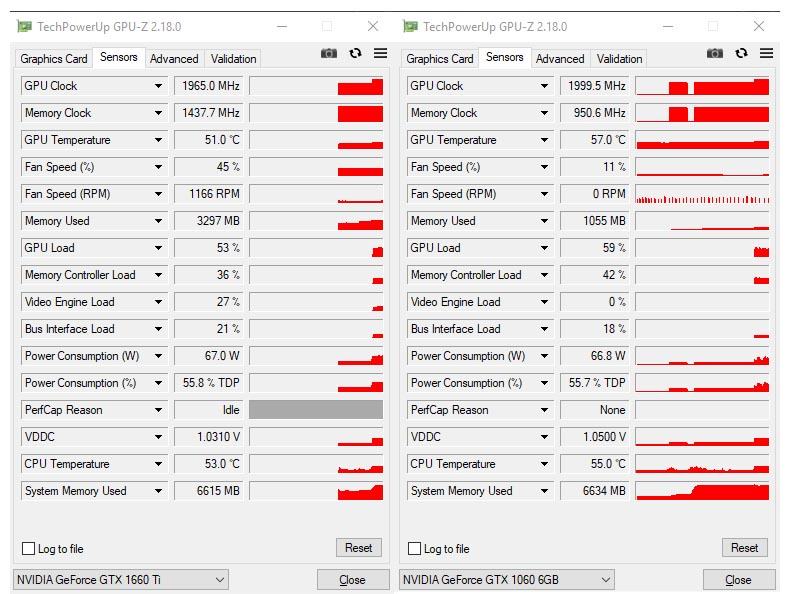

NVIDIA GeForce GTX 1660 Ti, GPU Load - 53%, тактовая частота - 1965МГц, было утилизировано 3297 Мб видеопамяти GDDR6.

NVIDIA GeForce GTX 1060 6Gb, GPU Load - 59%, тактовая частота - 1999МГц, было утилизировано 1055 Мб видеопамяти GDDR5.

Итоговое время рендеринга: 18 секунд.

Итоговый график (чем меньше время, тем лучше):

*У NVIDIA GeForce GTX 1060 6GB мы увидели загрузку 100%, это явилось "узким местом", поэтому время сдвинулось с 18 секунд до 20 секунд. С другой стороны NVENC движок у архитектуры Turing на 10-15% быстрее, чем в архитектуре Pascal. И соответственно снова получаем не чистое GPU тестирование, так как вклад в результат мог внести именно NVENC. Поэтому иногда используются в тестах "странные" форматы, именно для того чтобы тестировать разницу в GPU производительности, убирая другие "узкие места" из уравнения.